|

El volumen del cuerpo representado

por las isolíneas de espesor (isopacas) se puede calcular

por el método de la red milimétrica.

En esta variante es necesario trazar los mapas de isovalores del espesor,

ley de los componentes

útiles y masa volumétrica. Posteriormente se superpone

una malla o matriz de bloques, cuyo

tamaño está en correspondencia con la escala de los trabajos y la

densidad de la red de

exploración. La matriz divide toda el área del

yacimiento en pequeños bloques cuadrados. Posteriormente a

partir del mapa de isopacas se interpola el valor de la potencia en el centro de cada

bloque lo cual permite determinar el volumen de cada celda

elemental. Por la adición de estos volúmenes

elementales (ΔV) se determina el volumen total del

yacimiento. Si se considera necesario para mejorar la

precisión en los bloques limítrofes, se puede estimar

la proporción del bloque que se localiza dentro de los

contornos del yacimiento.

ΔV=ΔS*mi

Donde ΔV -volumen elemental de la celda o bloque

![]()

mi – espesor del yacimiento en el centro del área parcial,

se determina por interpolación

Δs -área de la celda (valor constante)

El volumen total del cuerpo se calcula:

![]()

De esta expresión queda claro que el volumen de un

yacimiento se determina como el producto del área

elemental del bloque con la suma de los espesores parciales que

se determinan por interpolación lineal a partir de las

isolíneas.

El cálculo de las reservas de

menas del yacimiento es exactamente igual si la masa

volumétrica es variable se construye el mapa de isovalores

de este parámetro y a partir de aquí se interpola

el valor "d" en cada celda.

![]()

Si d es constante entonces la formula queda de la siguiente

forma

![]()

De forma análoga se estima la cantidad de metal

![]()

Esta variante del método de isolíneas es

extremadamente importante pues contienen en esencia la idea

fundamental sobre la que descansan los métodos modernos asistidos

por computadoras. En ellos

también se subdivide o discretiza el yacimiento en

pequeños bloques y posteriormente se estima en cada celda el

valor de la variable de interés, con la única

diferencia que en los métodos actuales la interpolación

se basa en métodos de estimación espacial

(geoestadísticos y geomatemáticos). La comprensión

de esta variante es fundamental para poder entender los

métodos que serán discutidos en los próximos

capítulos.

En resumen se puede decir que una de las ventajas del

método de isolíneas es su claridad pues las curvas de

isovalores brindan una idea clara sobre la constitución del yacimiento

y el comportamiento de los

espesores y contenidos del componente útil. Para trazar las

isopacas no es necesario emplear espesores reales sino que se

puede usar la componente vertical u horizontal de la potencia,

todo depende del plano en el que se proyecte el cuerpo. El

método permite realizar estimaciones locales (bloque a

bloque) lo cual facilita la utilización de los resultados

para fines de planificación minera.

Según la literatura la principal desventaja del

método radica en la complicación de las construcciones,

la cual ha sido superada con la introducción de los

ordenadores y el desarrollo de los métodos

geoestadísticos. El principal problema del método

está en la necesidad de contar con un grado de

exploración alto pues la construcción de las

isolíneas sobre la base de una red de exploración poco densa no es

confiable.

El método de estimación mediante cortes o perfiles

se puede usar si el yacimiento fue explorado en una red regular

que permite la construcción de cortes geológicos. Los

cortes geológicos de un yacimiento, según su

orientación, pueden ser horizontales, verticales o perfiles

no paralelos. La distancia ente los cortes

particulares no es constante y corresponde a la distancia entre

las líneas de exploración en el caso de perfiles

verticales o la altura entre niveles de una mina en el caso de

cortes horizontales.

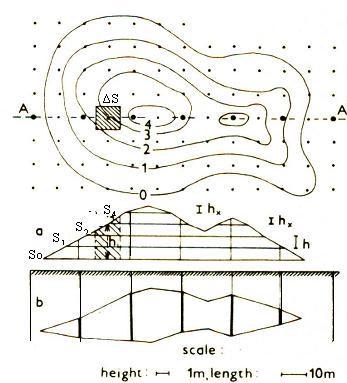

Figura 2.7 Cálculo de recursos usando el método de

perfiles paralelos. Para simplificar el esquema solo se

trazó el contorno externo. 1-Pozos positivos y

negativos 2-número de los perfiles geológicos

3-número de los bloques de cálculo 4-intercalación

de roca estéril, S – área del cuerpo en los

perfiles L- distancia entre los perfiles

La sucesión de cálculo en este caso es la

siguiente.

·

Contornear el cuerpo mineral (contorno interno y externo) en el

plano.

· Se

dibujan los perfiles a una escala dada, incluyendo en los mismos

los resultados del contorneo (Fig. 2.7).

· Se

calculan las áreas en los perfiles por su semejanza con

figuras geométricas sencillas

· Se

calculan los volúmenes entre perfiles utilizando las

siguientes fórmulas:

Cuando la diferencia entre las áreas calculadas no supera

el 40 % se utiliza la fórmula del trapezoide

Vi-ii = (S1+S2)/2 x L

Si y Sii -áreas de los perfiles contiguos

L – distancia entre perfiles

Si la diferencia es mayor del 40 % se utiliza la fórmula

del cono truncado

Vi-ii = ![]() x L

x L

El cálculo del volumen en los flancos se realiza por las

fórmulas de la cuña o el cono en dependencia de la

forma aproximada del bloque en los extremos.

V cuña =1/ 2 S*L

Vcono=1/3Sx L

·

Estimación de los valores promedios de los

parámetros para cada bloque (ley del componente

útil)

Estimación de la ley media de cada perfil limítrofe

a partir de la media aritmética o media ponderada por la

potencia.

Ci = (C1*m1+C2*m2+

+Cnmn)/ (m1+ m2+

+mn) (perfil I)

Cii= (C1*m1+C2*m2+

+Cnmn)/ (m1+ m2+

+mn) (perfil II)

Posteriormente se calcula el valor medio del bloque ponderando

por el área de cada perfil.

Ci-ii = (Ci Si +CiiSii)/(Si+Sii)

Se calcula el valor promedio de la masa volumétrica para

cada bloque usando el mismo procedimiento

- Cálculo de las reservas de menas y del componente

útil en cada bloque

Qi-ii = Vi-ii*di-ii

Pi-ii = Qi-ii*Ci-ii

·

Cálculo de las reservas totales del yacimiento por la

sumatoria de las reservas de los bloques individuales

Qt = Qi-ii + Q ii-iii +

······ +

Qn-1,n

Pt = Pi-ii + P ii-iii +

·········· +

Pn-1,n

El método de las secciones en todas sus variantes permite

tener en cuenta de manera más completa las

particularidades de la constitución geológica del

yacimiento, la morfología y las

condiciones de yacencia de los cuerpos minerales (Lepin y Ariosa, 1986).

El método posee desventajas importantes. En primer lugar se

basa en la interpolación rectilínea de los datos de exploración entre

las secciones contiguas y por eso es inaplicable si la

estructura tectónica del

objeto es compleja. Además si distancias entre los perfiles

son grandes se puede incurrir en errores groseros en la

determinación de los volúmenes. Por este motivo, no se

recomienda este método durante los

estadios iniciales del estudio geológico del yacimiento,

especialmente si se supone una constitución geológica

compleja. En segundo lugar, al calcular las reservas de mineral

útil mediante este método no se utilizan los

datos de exploración obtenidos en los puntos dentro

del bloque, sino solo los ubicados en las secciones principales

de exploración.

3 Análisis exploratorio de

datos

3.1 Compositación o

regularización

Generalmente los intervalos de muestreo en los pozos de

exploración no coinciden con los intervalos de trabajo en la fase de

estimación de recursos. Los intervalos de muestreo son

siempre menores pues se busca revelar la variabilidad espacial de

las variables que se estudian. El

cálculo de los compósitos no es más que un

procedimiento mediante el cual

las muestras de los análisis se combinan en intervalos

regulares (igual longitud), que no coinciden con el tamaño

inicial de las muestras. La ley del nuevo intervalo se calcula

usando la media ponderada por la longitud de los testigos que

contribuyen a cada compósito y la masa volumétrica en

caso de ser variable. El objetivo de la

regularización según Barnes, 1980 es obtener muestras

representativas de una unidad litológica o de

mineralización particular las cuales pueden ser

usadas, a través de una función de extensión,

para estimar la ley de un volumen mucho mayor de la

misma unidad.

Entre las principales razones y beneficios de la

regularización tenemos:

El análisis geoestadístico exige muestras de igual

longitud (similar soporte).

La compositación reduce la cantidad de datos y por

consiguiente el tiempo de cálculo o

procesamiento.

Se producen datos homogéneos y de más fácil

interpretación.

Se reduce las variaciones erráticas (alto efecto pepita)

producto de muestras con valores extremadamente

altos.

El proceso incorpora la

dilución como la provocada por la explotación de

banco con altura constante en

la minería a cielo abierto.

Existen muchos tipos de yacimientos minerales cada uno de los

cuales requiere de un tratamiento específico de los

datos de las muestras de manera que se logren los mejores

intervalos de compositación para la evaluación del los mismos

(Barnes, 1980). Básicamente existen 3 tipos principales de

compósitos y se usan en dependencia de la naturaleza de la

mineralización y el método de explotación:

Compósito de Banco (bench composite): Las muestras se

regularizan a intervalos que coinciden con la altura de los

bancos o una fracción de

esta. Se emplea para modelar los recursos de yacimientos grandes,

diseminados de baja ley que se explotan con minería a cielo

abierto (Yacimientos de Cobre

porfídico).

Compósito de Pozo (down hole composite): Las

muestras se combinan a intervalos regulares comenzando desde la

boca del pozo.

Compósito Geológico (geological composite): Las

muestras se combinan a intervalos regulares pero respetando los

contactos geológicos entre las distintas unidades. Este

método se emplea para prevenir la dilución del

compósito en el contacto estéril mineral y donde se

logra mayor control sobre el proceso de

regularización.

El empleo de compósito de

banco o de pozo en estos casos provoca una distorsión de la

distribución de la ley ya

que se puede adicionar mineral de baja ley a la zona mineral o

mineral de alta ley al estéril.

Para escoger la longitud de regularización se emplean las

siguientes reglas empíricas:

· El

tamaño del compósito se selecciona entre la

longitud media de las muestras y el tamaño del banco

· Para el

caso de los cuerpos en los que su análisis se hace de forma

bidimensional, es necesario computar por pozos una media

ponderada de los valores de todas las variables de interés

que abarque todas las muestras positivas del intervalo

mineralizado.

·

No se debe regularizar muestras grandes en intervalos

más pequeños pues se introduce una falsa idea de

continuidad espacial (fig. 3.1).

|

Figura 3.1 Impacto provocado al regularizar

muestras grandes en intervalos pequeños.

3.2 Análisis

exploratorio de datos.

Antes de proceder con la estimación de reservas

propiamente dicha se debe, siempre que sea posible, realizar un

análisis estadístico de los datos disponibles o los

generados a partir del cálculo de los compósitos con el

objetivo de caracterizar el comportamiento estadístico de

las distintas variables en el depósito y en las unidades

geológicas (dominios) que lo integran.

La organización de los datos

cuantitativos y su análisis pueden consumir el 50 % de

tiempo necesario para realizar la estimación de reservas. El

análisis exploratorio de datos está dirigido a resolver

las siguientes cuestiones:

·

Identificar y eliminar los posibles errores

·

Caracterización estadísticas de las

variables de interés

·

Documentar y entender las relaciones entre las variables

· Revelar

y caracterizar la continuidad espacial de las variables

(potencia y contenido del componente útil)

·

Identificar y definir los dominios geológicos que requieren

un tratamiento independiente durante la estimación de

recursos.

·

Identificar y caracterizar las muestras con valores extremos

(outliers)

El cálculo de la estadística básica y

el estudio de la distribución de frecuencias de los

parámetros constituyen las principales herramientas que posibilitan

el análisis estadístico de los datos. Los resultados de

esta etapa complementan el modelo geológico y se

emplean en la modelación de recursos.

La estadística básica se calcula para las muestras

originales y compositadas en cada dominio geológico, los

cuales incluyen distintos tipos litológicos, tipos de

alteración hidrotermal, dominios estructurales y zonas

o sectores en las que se reconoce (o se sospecha) que la

distribución estadística de la variable es

diferente.

El análisis estadístico comienza con el estudio de

la distribución de frecuencia la cual indica como se

distribuyen las muestras en intervalos regulares de los posibles

valores. A partir de aquí se construyen los

histogramas y gráficos de frecuencia

cumulativa. El estudio del histograma permite extraer

conclusiones sobre el tipo de distribución que siguen los

datos, la presencia de valores huracanados y la posible

existencia de poblaciones complejas (bimodalidad).

Al histograma calculado se le ajusta un modelo teórico de

distribución. En la práctica de la estimación de

recursos se emplean mayoritariamente el modelo de

distribución normal o gaussiana y el modelo lognormal de 2 y

tres parámetros.

Si el histograma del parámetro estudiado es

simétrico en forma de campana y la distribución de

frecuencia cumulativa se plotea como una línea recta en el

papel probabilístico normal entonces los datos se ajustan al

modelo de distribución gaussiano. Este tipo de modelo se

observa poco en los yacimientos minerales excepto en aquellos de

origen sedimentario.

La función de densidad de probabilidades que

describe matemáticamente esta distribución esta

dada por la siguiente ecuación

Donde

f(x)- función de densidad de probabilidad

m – media

σ- desviación estándar

El gráfico de la función de densidad de

probabilidad, conocida como

curva normal, se muestra en la figura 3.2.

|

Figura 3.2 -Gráfico de la distribución normal

Una propiedad muy útil de la

distribución normal es que el área bajo la curva en un

intervalo específico puede ser fácilmente calculada.

Por ejemplo, el 68 % de los valores de la variable caen en el

intervalo μ±σ, el 95% en el intervalo

μ±2σ y el 99% en el intervalo

μ±3σ.

Si el histograma del parámetro estudiado es

asimétrico, formando una cola hacia la derecha y la

frecuencia cumulativa se grafica como una línea recta en el

papel probabilístico lognormal entonces los datos se ajustan

al modelo de distribución lognormal. Cuando los datos poseen

estás características la variable original se

transforma calculando el logaritmo natural de sus valores. El

histograma de la variable transformada se ajusta al modelo

gaussiano.

Este tipo de distribución se encuentra en muchos problemas de evaluación

de reservas, donde existe una gran cantidad de valores bajos y

unos pocos valores altos que definen el yacimiento.

La función de densidad de probabilidades que describe

matemáticamente la distribución lognormal

esta dada por la siguiente ecuación.

![]()

Donde a – media de los logaritmos de x

b –

desviación estándar de los logaritmos de x

Los gráficos de probabilidad o frecuencia acumulada

(normal o lognormal) son también de mucha utilidad para este análisis.

En primer lugar permite corroborar el modelo de distribución

al que se ajusta la variable y también calcular los

principales parámetros estadísticos que describen la

distribución. En muchos casos los gráficos obtenidos al

representar la frecuencia acumulada no constituyen líneas

rectas sino múltiples segmentos y curvas con sus respectivos

puntos de inflexión. Estos puntos de cambios de pendiente se

emplean para separar poblaciones complejas, siempre y cuando las

subpoblaciones posean coherencia espacial y una lógica

explicación geológica..

Una desviación típica de los gráficos de

probabilidad es una curva hacia abajo en el extremo inferior.

Esta curva representa un exceso de muestras con leyes bajas comparado con lo que

se debe esperar si la distribución fuese lognormal. En los

depósitos de cobre porfídico, por ejemplo, esto se

explica por intrusiones tardías débilmente

mineralizadas o diques estériles posteriores a la

mineralización. Los datos deben ser examinados para

determinar la fuente de las muestras de bajo contenido y valorar

si esta población ha sido o puede

ser cartografiada y estimada de forma independiente. Este

mismo comportamiento del gráfico de probabilidad puede

originarse al representar una distribución normal en un

papel probabilístico lognormal.

Otra desviación muy común de la línea recta en

el gráfico de probabilidades es una curva de mayor pendiente

en el extremo superior. Esto representa un exceso de muestras con

alto contenido lo cual puede ser causado por la

superposición de 2 poblaciones. Un ejemplo de esto puede ser

vetas de alta ley que cortan mineralización diseminada de

baja ley. Otras causas de muestras con valores muy altos pueden

ser los pequeños sectores dentro del cuerpo altamente

favorables para hospedar mineralización producto de su alta

permeabilidad, propiedades químicas favorables,

enriquecimiento secundario o removilización

metamórfica. Como la mineralización de alta ley

generalmente posee menor continuidad que la de baja ley el

origen de estas zonas debe ser identificado y su estimación

realizada de forma independiente.

Una vez obtenidos los histogramas y gráficos de

probabilidades se calculan algunos parámetros de la estadística descriptiva que

caracterizan numéricamente la distribución

estadística.

Los principales estadígrafos que deben ser

calculados para las distintas variables son:

Números de datos (muestras o compósitos)

Medidas de tendencia central (media, moda, mediana)

Medidas de dispersión (varianza, desviación

estándar, rango y coeficiente de variación)

Medidas de forma (asimetría y kurtosis)

3.2.1.1 Medidas de tendencia central

La media aritmética es el promedio de los n

valores medidos. Posee el inconveniente de que es muy sensible a

la presencia de valores extremos en los datos. La media o

esperanza matemática se calcula por la

fórmula siguiente

La moda es valor más probable o frecuente de la variable

estudiada

|

La mediana es el punto central de los valores

observados si se organizan en orden ascendente. La mitad de los

valores caen por debajo de la mediana y la otra mitad por encima.

Cuando la variable se ajusta al modelo normal la moda, la

mediana y la media coinciden, si la distribución es

lognormal, la moda es mayor que la mediana y esta a su vez

es mayor que la media.

Cuando la distribución es asimétrica los valores

medios de la ley u otro

parámetro estimados a partir de una simple media

aritmética están sesgados y no se confirma

posteriormente durante la producción. Si los datos

se distribuyen lognormalmente, la población se puede definir

como una población lognormal de dos parámetros (media y

la varianza de la población logarítmica), entonces el

valor medio de este tipo de distribución se obtiene

por la fórmula siguiente:

m = e[a+

var/2]

Donde:

m = Valor medio estimado de la variable

a = Media de la distribución de los logaritmos de la

variable

var = varianza de la distribución de los logaritmos de

variable.

Los valores a y var pueden ser calculados por las

fórmulas anteriormente descritas o estimados a partir del

gráfico de probabilidad (fig. 3.5). La media de los

logaritmos coincide con el percentil 50 mientras que la

desviación estándar es SD

=0.5(X16-X84).

Puede ocurrir que al representar los datos logarítmicos

en un diagrama de probabilidad,

estos no se ajusten exactamente a una recta, mostrando una cierta

curvatura en el comportamiento, lo que es indicativo de la

presencia de una población lognormal de tres parámetros

(Fig. 3.5). Este tercer parámetro, denominado constante

aditiva (a), se puede calcular como:

a = [ x50 – ( x75 . x25 ) ] /

(x25 + x75 – 2.x50)

donde x25, x50 y x75

los valores de los percentiles 25, 50 y 75.

Este valor a se añade a la población original de

datos. A continuación, se realiza la transformación

logarítmica obteniéndose una nueva población

ln(xi + a), la cual si se ajusta a una

distribución lognormal. El valor de a estimado por este

método es tentativo y puede ser modificado de modo que se

logre el mejor ajuste posible.

|

Figura 3.5 Gráficos de probabilidad de una

distribución lognormal a)población lognormal de 2

parámetros b) población lognormal de 3

parámetros.

Para calcular, en este caso, la media del parámetro se

aplica el procedimiento descrito para la población de dos

parámetros, sustrayéndose el valor de la constante

aditiva al resultado final.

Varianza: La varianza de los

datos,se

calcula de acuerdo a:

La varianza es la desviación cuadrática promedio de

los datos respecto a su valor central, esta medida es sensitiva a

valores extremos.

Desviación estándar: La desviación

estándar se calcula como la raíz cuadrada de la

varianza. Esta medida con frecuencia se prefiere en lugar de la

varianza debido a que sus unidades son las mismas que la variable

que se estudia.

Rango: Es la diferencia entre el máximo y el

mínimo.

Coeficiente de simetría: El descriptor más

utilizado para medir la forma de la distribución es el

coeficiente de asimetría. Debido a la manera en que se

calcula este coeficiente los valores del mismo pueden estar

afectados por la presencia de valores extremos en los datos. Un

sólo valor extremo puede influenciar notablemente este

coeficiente pues la diferencia entre cada valor y la media es

elevado al cubo. La distribución normal estándar es

perfectamente simétrica, Sk = 0. Esta

medida se calcula como:

|

Sk < 0 Distribución asimétrica

negativa

Sk = 0 Distribución simétrica

Sk > 0 Distribución asimétrica

positiva

Coeficiente de variación: Este coeficiente se usa

como una alternativa al coeficiente de asimetría. Se emplea,

principalmente, para distribuciones en las cuales todos sus

valores son positivos y cuya asimetría es también

positiva. Aunque puede ser utilizado para distribuciones

con asimetría negativa en ellas su importancia como

índice de forma decrece considerablemente. Este coeficiente

es una medida de dispersión adimensional, y no

está definido para el caso en que la media es cero. Se

calcula como la desviación estándar dividida por la

media de los datos.

![]()

Un coeficiente de variación mayor que uno indica la

presencia de algunos valores erráticos en la muestra

los cuales pueden tener una gran influencia en la

estimación.

Según Finney (1941) una manera práctica de saber si

los datos se ajustan a una distribución normal o lognormal

es calcular el coeficiente de variación y verificar si este

es mayor o menor que 1.2; si es mayor que este valor (gran

dispersión de los valores) entonces la distribución es

lognormal, en caso contrario el modelo es normal.

Noble, 2000 propone las siguientes reglas para interpretar el

coeficiente de variación.

Coeficiente de variación | Interpretación |

0-25 % | Distribución simple y simétrica de la |

25-100% | Distribución asimétrica. Dificultad moderada |

100 – 200 % | Distribución marcadamente asimétrica con un |

> 200 % | Distribución asimétrica y muy errática o |

Kurtosis: Es una medida de cuan "afilado" es el pico de

la distribución de los datos. Tradicionalmente el

valor de este coeficiente se compara con cero, el cual es el

valor para el caso de una distribución normal. Un

valor mayor que cero indica una distribución más picuda

que la normal y un valor menor que cero refleja una

distribución más achatada que la normal. Sin un

número de muestras grandes, el uso de este coeficiente es de

dudoso valor.

|

Si el número de muestras es mayor que 25 entonces es

posible hacer comparaciones de la media y el coeficiente de

variación de las variables de interés entre los

distintos dominios geológicos presentes en el

yacimiento.

Noble, 2000 propone las siguientes reglas generales para

evaluar las diferencias entre las leyes medias:

Diferencia de la ley media entre dominios | Interpretación |

0-25 % | La diferencia es mínima y no es necesario |

25-100% | Las poblaciones requieren ser diferenciadas en el modelo |

Mayor de 100 % | Las poblaciones tienen que ser necesariamente |

4

Métodos de estimación de reservas asistido por

computadoras

Los métodos de estimación de recursos asistido por

computadoras se han desarrollado ampliamente en los últimos

años debido al desarrollo vertiginoso que han tenido los

ordenadores y los softwares de aplicación. Los

primeros intentos estuvieron dirigidos a informatizar los

métodos clásicos o geométricos (método de los

polígonos y de los

perfiles) posteriormente con el desarrollo de la

geoestadística aparecieron métodos más potentes y

con una filosofía totalmente

diferente de trabajo.

Los métodos asistido por computadoras permiten realizar

estimaciones en bloques más pequeños (estimación

bloque a bloque, que idealmente deben ser del tamaño de la

unidad de selección minera) definidos

en función del objetivo de la estimación y la densidad

de la red de exploración. En esto radica precisamente

la diferencia con los métodos clásicos o

geométricos los cuales, como se conoce, definen el

tamaño del bloque sobre la base de conceptos de área o

volumen de influencia que comúnmente son determinados

empíricamente, o también de acuerdo con la

disposición de las intersecciones de exploración. Estos

bloques así definidos son de grandes dimensiones y se

evalúan generalizando la variable estudiada a partir de la

media aritmética o la media ponderada según sea el

caso.

Los métodos computarizados para la estimación de

recursos se basan en procedimientos matemáticos de

interpolación local y solamente emplean los datos de

los pozos vecinos al bloque para realizar la estimación de

la variable estudiada. Un esquema simplificado de la

estimación de recursos asistida por computadora se muestra en la

figura 4.1. El yacimiento o la zona mineral definido por la

geología se discretiza en

una matriz de bloques bidimensional o tridimensional según

el caso y cada bloque se estima utilizando los datos localizados

dentro del área o volumen de búsqueda.

Los métodos de ventanas móviles (inverso de la

distancia y kriging) son las técnicas más empleadas

en la estimación de recursos asistida por

computadora.

El procedimiento general de los métodos computarizados es

el siguiente.

1. Confección de la

base de datos con toda la

información relevante de la

exploración del yacimiento

2. Análisis

exploratorio de datos y variografía

3. Creación del

modelo geológico

4. Modelo de recurso –

División del yacimiento mineral en una matriz de bloques

regulares -modelo de bloque o capa.

5. Estimación en cada

bloque de las variables de interés (contenido, masa

volumétrica etc.) empleando una técnica de

interpolación espacial (funciones de extensión). El

valor estimado de la ley en cada celda se calcula por la

siguiente fórmula:

Z*(x) = åi=1,n

Wi Z (xi) i= 1,2,3,…….n

Donde: Wi es el peso o coeficiente de

ponderación asociada a cada muestra y su valor depende del

método de estimación espacial empleado, n es la

cantidad de muestras seleccionadas para hacer la

estimación.

Figura 4.1 Representación bidimensional del caso general

de la estimación de recursos asistida por

computadoras (Según Sinclair y Blackwell, 2002)

A continuación se describe detalladamente cada una de

estas etapas. Mucho de los aspectos aquí discutidos para los

métodos asistidos por computadoras son igualmente

válidos para los tradicionales o geométricos

4.1 Confección de la base de

datos

La estimación de recursos/reservas a partir de un

número limitado de pozos es una de las tareas más

complejas que enfrenta un geólogo explorador. En la

medida que avanza la exploración y se van recopilando datos

relevantes del yacimiento estos se van organizando en una base de

datos. El geólogo debe garantizar la integridad de la misma

y tomar las medidas necesarias para evitar los errores de

trascripción o digitalización.

La precisión y exactitud de la estimación de

reservas depende de la confiabilidad de los datos sobre los

cuales se basa y ningún método de estimación, por

muy sofisticado que sea, puede compensar la mala calidad de los datos (Burn,

1981). Queda claro que contar con una buena base de datos es la

garantía de una correcta estimación de reservas. Por

esta razón, desde el mismo comienzo de los trabajos es

necesario implementar procedimientos que garanticen un muestreo

representativo y un estricto control sobre la calidad de

los resultados del laboratorio.

La base de datos debe integrar todo tipo de datos incluyendo

litología, documentación, resultados

de los análisis, registros de carotaje, datos

hidrogeológicos y geotécnicos.

Los datos de exploración (pozos, galerías,

trincheras etc.) generalmente se guarden en 3 o 4 tablas

Tabla 1 recoge la posición espacial del pozo y

está conformada por los siguientes campos: Nombre del pozo

(DDH;BH), coordenadas X;Y;Z de la boca del pozo (collar),

profundidad y otros datos adicionales como tipo de

perforación, año de la campaña etc.

Tabla 2 recoge los datos de inclinometría que

permiten determinar la posición de las muestras en el

espacio. Campos: Nombre del pozo, profundidad de la medición, azimut y

ángulo de inclinación o ángulo cenital

Tabla 3 recoge los datos referentes a las muestras

tomadas (testigos) su descripción (litología

codificada) y los resultados de los análisis químicos.

Campos: Nombre del pozo, desde, hasta, # de la muestra,

litología, análisis químicos. Esta tabla en

ocasiones se desdobla en dos, una para los análisis

químicos y otra para la litología, pues la longitud de

los intervalos generalmente no coincide.

Una vez que la base de datos ha sido compilada el geólogo

debe validarla e identificar y eliminar todos los posibles

errores. La mejor manera de comprobar la integridad de la base de

datos es mostrando la información en perfiles y comparar con

el modelo que se tiene del yacimiento. También se acostumbra

a comparar un porcentaje (10%) de los registros con la

información original.

La etapa siguiente tiene como objetivo caracterizar

estadísticamente cada una de las variables estudiadas y

cuantificar su variabilidad espacial. Estos aspectos son tratados en capítulos

independientes (capítulos 3 y 5).

4.2 Creación del modelo

geológico

La experiencia ha demostrado que el problema principal en la

estimación de recursos no esta relacionado directamente con

el método de estimación empleado sino con la correcta

aplicación de los principios geológicos. La

cuestión medular a resolver antes de la estimación de

recursos propiamente dicha es establecer la continuidad de la

mineralización y la ley dentro del yacimiento. Un muestreo

representativo, análisis confiables y una coherente

interpretación geológica son los componentes

principales de la estimación de recursos (Arseneau y Roscoe,

1997)

La interpretación geológica siempre se basa en los

datos y en el conocimiento que posee el

geólogo sobre el yacimiento o del modelo de yacimiento que

se estudia. Esto conduce inevitablemente a que los mismos datos

sean interpretados de forma diferente por distintos

especialistas, y por consiguiente resultados diferentes de la

estimación de recursos.

La interpretación geológica tradicionalmente ha

descansado en la construcción de planos y secciones en los

cuales se representa la morfología, dimensiones y

propiedades del yacimiento (Popoff, 1966). La interpretación

de todos los datos recopilados durante la exploración

se basa en 3 enfoques principales:

·

Interpretación basada en perfiles y secciones

·

Interpretación basada en planos de isolíneas

·

Principio de analogía o inferencia geológica.

En la actualidad aunque el proceso se ha informatizado el

procedimiento continúa siendo el mismo y se basa en los

enfoques anteriormente descritos.

En los métodos de estimación asistidos por

computadora el conocimiento geológico

que posee el geólogo sobre la continuidad de la estructura y

la ley se traduce en la definición de zonas o dominios

geológicos que poseen una forma geométrica

única.

Los dominios geológicos no son más que zonas

geológicamente y estadísticamente homogéneas. Lo

que realmente se hace cuando se crea el modelo geológico del

yacimiento es subdividir el mismo en subpoblaciones que cumplan o

se aproximen a la hipótesis de

estacionaridad (ver capitulo 5). La división del yacimiento

en dominios siempre debe basarse en el conocimiento

geológico y el sentido común. Guibal (1997)

señala que la selección de los dominios

geológicos debe estar respaldada y validada por la

estadística y la variografía.

La definición de los límites o contornos de los

dominios geológicos, los cuales determinan la geometría de los cuerpos y

zonas, es el método básico para aplicar control

geológico a la estimación durante la modelación de

recursos.

Los límites o contornos de los dominios

geológicos se clasifican en difusos o gradacionales

y físicos. En los yacimientos que están definidos

por limites físicos, (carbón, yacimientos

sedimentarios, filones de oro etc.), el trazado de los

contornos es relativamente fácil, pues estos coinciden con

los planos o contactos geológicos. En el caso de los

yacimientos gradacionales (Cobre porfirico) los límites se

definen sobre la base de una ley económica o

cutoff.

4.2.1 Métodos para

la definición de los contornos

Existen distintos métodos para correlacionar los

límites de los dominios y conformar las superficies o

sólido 3D que define la geometría de la unidad

geológica en el espacio tridimensional.

4.2.1.1 Sólidos a partir de los modelos de alambre o

wireframe.

El wireframe es la manera más versátil de definir

los límites de los dominios geológicos. Cualquier

límite o contorno interpretado en perfiles, planos o

directamente en 3D puede ser combinado para formar el modelo de

alambre y finalmente generar el sólido de la unidad

geológica.

Para generar el sólido a través de este método

se digitaliza interactivamente en la pantalla de la computadora los

límites o contornos de las unidades geológicas que

constituyen el depósito (fig. 4.2). La interpretación

de cada unidad en los perfiles es representada por un

polígono cerrado que posee una orientación y

posición espacial, un código que indica el

dominio geológico que encierra y una potencia o zona de

influencia lo que hace que cada perímetro englobe cierto

volumen.

Existen herramientas que garantizan que los contornos de

unidades contiguas en un perfil coincidan, de forma tal que no

queden huecos o espacios vacíos en el modelo

geológico.

|

Figura 4.2 Interpretación de los límites de los

dominios geológicos a partir de los datos mostrados en

perfiles.

Una vez que el mismo dominio geológico ha sido

interpretado en los distintos perfiles entonces se procede a

correlacionar la unidad geológica en perfiles

contiguos para lograr una representación 3D del cuerpo

geológico (fig. 4.3). Los perímetros (contornos)

digitalizados se van uniendo por los puntos de inflexión

correspondientes en los perfiles a través de líneas de

enlace (tie lines) hasta completar el wireframe que

encierra el volumen geológico 3D. Esta correlación

sección a sección se requiere cuando los contornos son

irregulares (bifurcaciones, fallas, acuñamientos, etc.).

Si las unidades geológicas muestran una clara

continuidad en 3D entonces no es necesaria la correlación

interactiva y se puede prescindir de las líneas de enlace,

en su lugar se usa un algoritmo de

interpolación lineal de los límites en las

secciones

Los modelos sólidos creados pueden ser cortados por

planos de cualquier orientación y espaciamiento, esto nos

permite corroborar nuestras interpretaciones en otra dirección cualquiera.

Figura 4.3 Creación del modelo sólido 3D a partir

del perfiles previamente interpretados.

Como toda la información en los softwares de

modelación y estimación de recursos es manejada en el

espacio no es necesario realizar la interpretación de

los limites a partir de perfiles y planos, esta puede hacerse

directamente en el espacio 3D.

4.2.1.2 Sólidos generados partir de

superficies (Método de superficies)

Muchas veces es posible confeccionar los sólidos

modelando las superficies estructurales que limitan por encima y

por abajo los cuerpos geológicos. Este enfoque puede ser

empleado en yacimientos estratiformes de poca complejidad

estructural

Este método se realiza en 3 pasos fundamentales:

§

Extracción de los puntos que yacen en las superficies

(techo y piso) a partir de la intercepción de la traza del

pozo con los planos estructurales)

§

Modelación de las superficies (triangulación o

gridding)

§

Combinación de las superficies y generación del

sólido

Existen 2 variantes de modelación de

superficies:

Modelación de superficie por triangulación

La superficie de contacto se modela usando una red

optimizada de triángulos irregulares

(TIN) que conectan los puntos con coordenadas conocidas. La

triangulación se realiza en un plano de referencia que debe

ser paralelo a la superficie considerada, el mosaico de

triángulos se genera sobre la base de la coordenadas

X;Y mientras que la Z define la topología. Para generar

el TIN se utiliza el método de Delaunay (Voronoi,

Thiessen).

Cualquier superficie puede ser modelada (superficie

topografica, planos de fallas etc.), interceptada con el plano

del perfil (viewplane) y ser utilizada para controlar la

interpretación geológica. La modelación de estas

superficies controladoras es el primer paso en la modelación

geológica en 3D.

Para la triangulación se debe tener el máximo de

información posible sobre la superficie a modelar. Esta

información debe estar libre de errores o inconsistencias

como pueden ser puntos con las mismas coordenadas, curvas de

nivel que se corten (strings) o puntos que no residan en la

superficie.

El método de triangulación no suaviza y

respeta la información original, aspecto muy importante

cuando la Z del punto se conoce con bastante certidumbre

(superficie topográfica, planos de falla), puede ser

aplicado a superficies de cualquier orientación (horizontal,

inclinado o vertical), da la posibilidad de representar las

discontinuidades (breaklines) y no genera superficie más

allá de los puntos extremos.

Modelación de superficie por interpolación (malla

-gridding)

Representa la superficie como un malla o matriz bidimensional

(formato RASTER) y requiere la interpolación de la cota en

los nodos de la red. El método tiene el inconveniente que la

representación es solo en el plano horizontal, lo que limita

su uso para modelar superficies inclinadas, además suaviza

los datos originales al tener que interpolar. Para generar la

malla se utilizan diferentes técnicas de interpolación

espacial (inverso de la distancia, kriging, vecino más

cercano, etc.).

La combinación de las superficies controladoras permite

el sólido que representa el dominio geológico

estudiado.

4.3 Modelo de

recursos

Una vez obtenido el modelo geológico entonces resta

establecer la variación espacial de las distintas variables

de interés (leyes), además de determinar los recursos,

ley media y cantidad de metal en cada dominio geológico y en

el yacimiento en general.

El método más usado en la modelación de

recursos consiste en la discretización del espacio 3D

en bloques o celdas tridimensionales (voxels) (fig.4.5). Cada

celda contiene los atributos (litología, tipo de

mineralización etc.) y las mediciones (leyes, propiedades

físico mecánicas) del dominio geológico en que se

encuentra. Los atributos de los bloques se determinan sobre la

base de la intersección con el modelo geológico o su

posición respecto a una superficie triangulada y las leyes a

través de la estimación con técnicas de

interpolación espacial.

Figura 4.5 Modelo de bloque

El primer modelo de bloque fue utilizado a comienzos de los

años 60 por la Kennecott Koper Corporation en un

depósito de pórfido cuprífero. Se empleó para

describir la distribución espacial de las leyes y no la

geometría de los dominios geológicos.

Cada bloque debe contener toda la información disponible

en las fases de desarrollo de un proyecto:

litología-mineralogía, contenidos de metales, calidades en el caso del

carbón y rocas industriales, contenidos de

contaminantes, parámetros geomecánicos, datos

hidrogeológicos, etc.

Para definir el modelo de bloque es necesario establecer los

siguientes parámetros (Fig.4.6)

§

Posición del modelo: se especifica a partir de las

coordenadas del centroide del bloque llave (key block).

§

Extensión del modelo en las distintas direcciones X, Y, Z

(debe ser lo suficientemente grande para enmarcar la región

de interés)

§

Dimensiones de las celdas o bloques por la X, Y y Z.

§

Orientación del modelo definido (ángulo de

inclinación y el azimut)

§

Conjunto de variables a almacenar en el modelo con sus

correspondientes formatos: ley de los distintos metales, peso

volumétrico, litología, tipo tecnológico de mena

etc.

Con el objetivo de alcanzar una mayor resolución del

modelo de bloque en los límites de los cuerpos minerales se

utilizan bloques (sub bloques) con dimensiones menores que los

originales. También se pueden utilizar voxels con

tamaños variables en distintas partes del depósito (Ej.

zonas con diferente grado de estudio o continuidad

espacial). El modelo de bloques puede ser rotado y orientado de

manera que se ajuste a la estructura geológica y respete los

elementos de yacencia del yacimiento estudiado.

|

Figura 4.6 Parámetros que definen el modelo de bloque:

Posición del bloque llave (Xmorg, Ymorg, Zmorg), dimensiones

del bloque (dx, dy, dz), extensión del modelo (X (nx), Y

(ny), Z (nz).

Un aspecto de primordial importancia en el modelo de

bloque lo constituye la selección de las dimensiones

del bloque. Lo ideal en este caso es que el tamaño del mismo

coincida con la unidad de selección minera que será

empleada durante la explotación del yacimiento, sin embargo

en muchas ocasiones esto no es posible pues no se cuenta con la

densidad suficiente de información. Cabe destacar

también que al disminuir el tamaño del bloque se

aumenta el error de estimación, es decir, su ley se

determina con un alto grado de incertidumbre. Ahora bien, al

aumentar el tamaño del bloque las leyes son emparejadas

artificialmente. Según la teoría

geoestadística por lo menos un tramo del pozo debe quedar

dentro de cada bloque, y que estos tramos estén uno del otro

a una distancia menor que el alcance del variograma, o sea,

dentro de la distancia que se estima que una muestra tiene

influencia sobre la otra.

Este enfoque teórico en muchos casos no es

práctico desde el punto de vista técnico (demasiados

subbloques para poder respetar los límites del modelo

geológico y lograr una buena precisión en el

cálculo del volumen, distintas redes de exploración etc.) y

generalmente se prefiere examinar el yacimiento en unidades de

selección más pequeñas. Por esta razón se

asume la siguiente regla ampliamente manejada en la literatura:

el tamaño del bloque puede ser tan grande como el

espaciamiento medio de la red y no debe ser menor a

¼ o 1/3 del espaciamiento de esta

(Houlding, 1994; Duke et. al., 1991).

La determinación de las dimensiones óptimas del

bloque depende principalmente de:

- Variabilidad de las leyes.

- Continuidad geológica de la mineralización.

- Tamaño de las muestras y espaciamientos entre

ellas. - Capacidades de los equipos mineros.

- Taludes de diseño de la

explotación.

Aunque el modelo de bloques es el más empleado en la

práctica este es más apropiado para depósitos de

forma isométrica. Para yacimientos relativamente planos como

pueden ser los yacimientos estratiformes y tabulares, es

preferible estimar las reservas en 2D, para lo cual se proyecta

el cuerpo en un plano, se contornea y delimitan los dominios

geológicos, se superpone una matriz de bloque 2d y

finalmente se estima en cada bloque las variables de interés

empleando el método de inverso de la distancia o kriging. Un

procedimiento similar a este fue explicado en el método de

isolineas en el capítulo referente a los métodos

clásicos, con la diferencia de que en este caso se emplea un

método más sofisticado para la interpolación

espacial de las variables de interés.

Otra variante para este tipo de yacimiento es continuar

trabajando en 3D y emplear un modelo de capa o de

lámina, el cual es muy similar al modelo de bloque pero la Z

de los bloques es variable y depende de la altura ente el

piso y el techo del cuerpo.

Se emplea en yacimientos donde su extensión horizontal es

mucho mayor que su dimensión transversal (espesor) y

donde la variación de la ley en esa dimensión es

despreciable o no se puede determinar (Filones, vetas,

yacimientos lateríticos y aluviales).

Página anterior Página anterior |   Volver al principio del trabajo Volver al principio del trabajo | Página siguiente  |