Hoy día, se entiende por minería de datos aquella disciplina que estudia la extracción automática de información sintetizada, relevante y con capacidad predictiva a partir de grandes bases de datos. Bajo este nombre se han agrupado recientemente diversas técnicas clásicas y modernas enfocadas a la visualización, análisis, y modelización de procesos a partir de grandes cantidades de datos (data warehouse de entidades financieras, comercio electrónico, empresas de marketing, industria, etc.). En este curso se pretende introducir al alumno en los conocimientos teóricos y prácticos involucrados en la minería de datos, utilizando diversos supuestos prácticos reales para ilustrar los distintos conceptos expuestos. Se trata de mostrar una panorámica actual de las técnicas involucradas y de introducir las herramientas informáticas necesarias para su aplicación práctica.

Objetivos y Contenidos

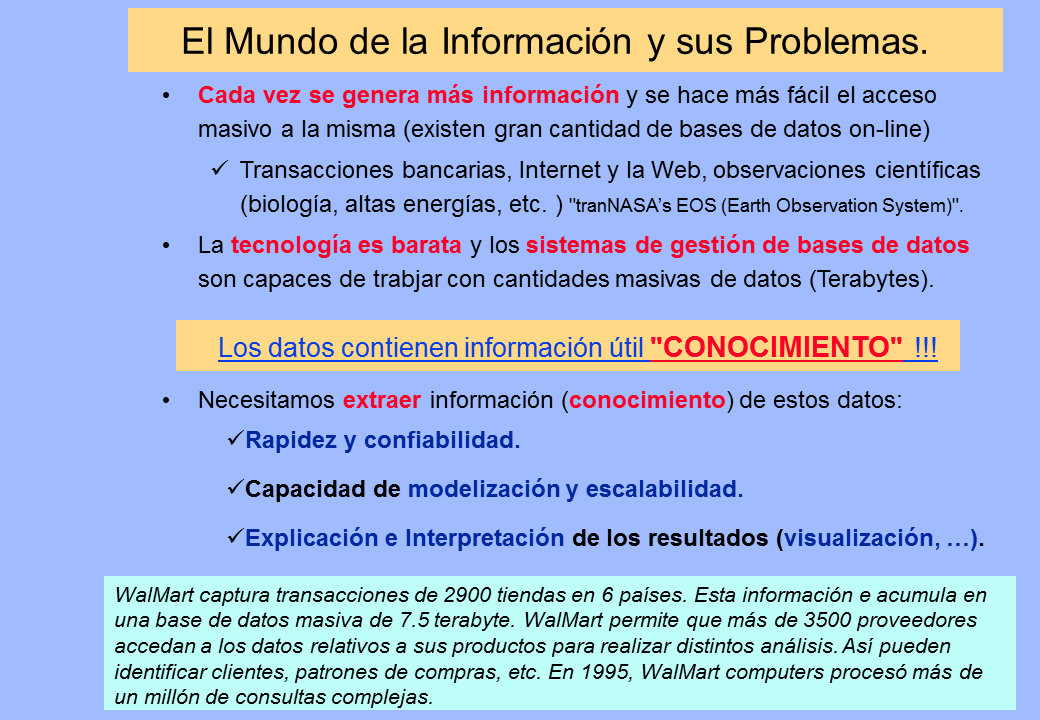

Cada vez se genera más información y se hace más fácil el acceso masivo a la misma (existen gran cantidad de bases de datos on-line)

Transacciones bancarias, Internet y la Web, observaciones científicas (biología, altas energías, etc. ) "tranNASA’s EOS (Earth Observation System)".

La tecnología es barata y los sistemas de gestión de bases de datos son capaces de trabjar con cantidades masivas de datos (Terabytes).

El Mundo de la Información y sus Problemas.

(Gp:) Los datos contienen información útil "CONOCIMIENTO" !!!

(Gp:) WalMart captura transacciones de 2900 tiendas en 6 países. Esta información e acumula en una base de datos masiva de 7.5 terabyte. WalMart permite que más de 3500 proveedores accedan a los datos relativos a sus productos para realizar distintos análisis. Así pueden identificar clientes, patrones de compras, etc. En 1995, WalMart computers procesó más de un millón de consultas complejas.

(Gp:) Rapidez y confiabilidad.

Capacidad de modelización y escalabilidad.

Explicación e Interpretación de los resultados (visualización, …).

(Gp:) Necesitamos extraer información (conocimiento) de estos datos:

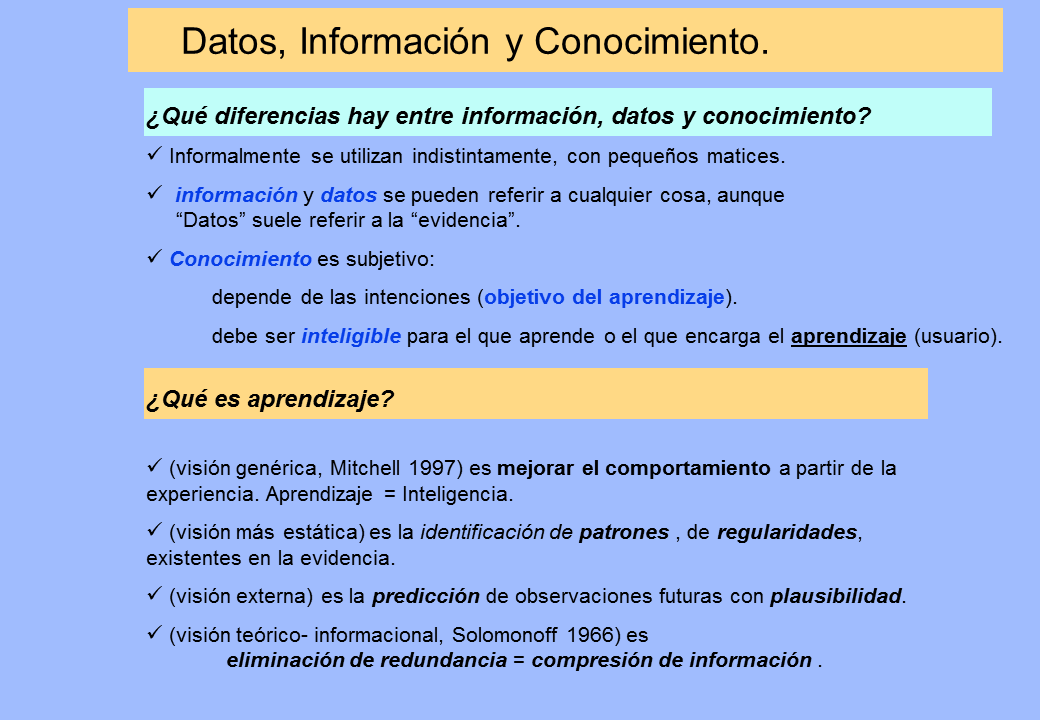

(Gp:) ¿Qué es aprendizaje?

(visión genérica, Mitchell 1997) es mejorar el comportamiento a partir de la experiencia. Aprendizaje = Inteligencia.

(visión más estática) es la identificación de patrones , de regularidades, existentes en la evidencia.

(visión externa) es la predicción de observaciones futuras con plausibilidad.

(visión teórico- informacional, Solomonoff 1966) es eliminación de redundancia = compresión de información .

Datos, Información y Conocimiento.

(Gp:) ¿Qué diferencias hay entre información, datos y conocimiento?

Informalmente se utilizan indistintamente, con pequeños matices.

información y datos se pueden referir a cualquier cosa, aunque “Datos” suele referir a la “evidencia”.

Conocimiento es subjetivo:

depende de las intenciones (objetivo del aprendizaje).

debe ser inteligible para el que aprende o el que encarga el aprendizaje (usuario).

Acceso a los Datos. Evolución histórica.

Bases de datos relacionales.

DBMS (Data Base Management Systems) y repositorios de información:

Bases de datos orientadas a objetos y objeto-relacionales.

Bases de datos espaciales (geográficas).

Bases de datos de texto y multimedia.

WWW.

La necesidad de almacenar información ha motivado históricamente el desarrollo de sistemas más eficientes, con mayor capacidad y más baratos de almacenamiento.

OLAP (On-Line Analytical Processing)

Sobre estas mismas bases de datos de trabajo ya se puede extraer conocimiento (visión tradicional).

Se mantiene el trabajo transaccional diario de los sistemas de información originales (conocido como OLTP, On- Line Transactional Processing ).

Se hace análisis de los datos en tiempo real sobre la misma base de datos( conocido como OLAP, On- Line Analytical Processing ),

Según la organización de la información copiada se distingue:

ROLAP (Relational OLAP): el almacén de datos es relacional.

MOLAP (Multidim OLAP): el almacén de datos es una matriz multidimensional.

(Gp:) Cada atributo relevante se establece en una dimensión, que se puede agregar o desagregar.

(Gp:) Para poder operar eficientemente con esos datos y debido a que los costes de almacenamiento masivo y conectividad se han reducido drásticamente en los últimos años, parece razonable recoger (copiar) los datos en un sistema unificado.

PROBLEMAS:

Disturba el trabajo transaccional diario de los sistemas de información originales (“ killer queries ”). Se debe hacer por la noche o en fines de semana.

La base de datos está diseñada para el trabajo transaccional, no para el análisis de los datos. Generalmente no puede ser en tiempo real (era AP pero no OLAP).

Data Warehouses. Génesis.

DATA-WAREHOUSES (Almacenes de Datos): Se separan de los datos a analizar con respecto a sus fuentes transaccionales (se copia/ almacena toda la información histórica).

Existe toda una tecnología creciente de cómo organizarlos y sobretodo de cómo tenerlos actualizados (cargas periódicas) respecto a los datos originales

Data Warehouses

Facilita el análisis de los datos en tiempo real (OLAP),

No disturba el OLTP de las bases de datos originales.

VENTAJAS:

A partir de ahora diferenciaremos entre bases de datos para OLTP (tradicional) y almacenes de datos (KDD sobre data warehouses).

Limpieza y criba selección de datos:

Se deben elmininar el mayor número posible de datos erróneos o inconsistentes (limpieza) e irrelevantes (criba).

Construcción de un Data Warehouse

(Gp:) Data Cleaning

(Gp:) Data

Warehouse

(Gp:) Databases

Se aplican métodos estadísticos:

-Histogramas (detección de datos anómalos).- Redefinición de atributos (agrupación o separación).

Muy relacionado con la disciplina de “Calidad de Datos”.

Acciones ante datos anómalos (outliers):

– Ignorar: algunos algoritmos son robustos a datos anómalos.- Filtrar (eliminar o reemplazar) la columna: solución extrema. – Discretizar: transformar un valor continuo en uno discreto (p. ej. muy alto, alto, etc.) hace que los outliers caigan en ‘muy alto’ o ‘muy bajo’ sin mayores problemas.

Acciones ante datos faltantes (missing values):

– Ignorar: algunos algoritmos son robustos a datos faltantes.- Filtrar (eliminar o reemplazar) la columna- Reemplazar el valor: por medias. A veces se puede predecir a partir de otros datos, utilizando cualquier técnica de ML.

¿Qué es Data Mining (minería de datos)?

Data Cleaning

Data Integration

Databases

Data

Warehouse

Task-relevant

Data

Selection

Data Mining

Pattern

Evaluation

CONOCIMIENTO

the non trivial extraction of implicit, previously unknown, and potentially useful information from data

W. Frawley and G. Piatetsky-Shapiro and C. Matheus, Knowledge Discovery in Databases: An Overview.

AI Magazine, Fall 1992, 213-228.

Datos imprecisos e incompletos

almacenados en múltiples fuentes

Heterogéneos y mezclados.

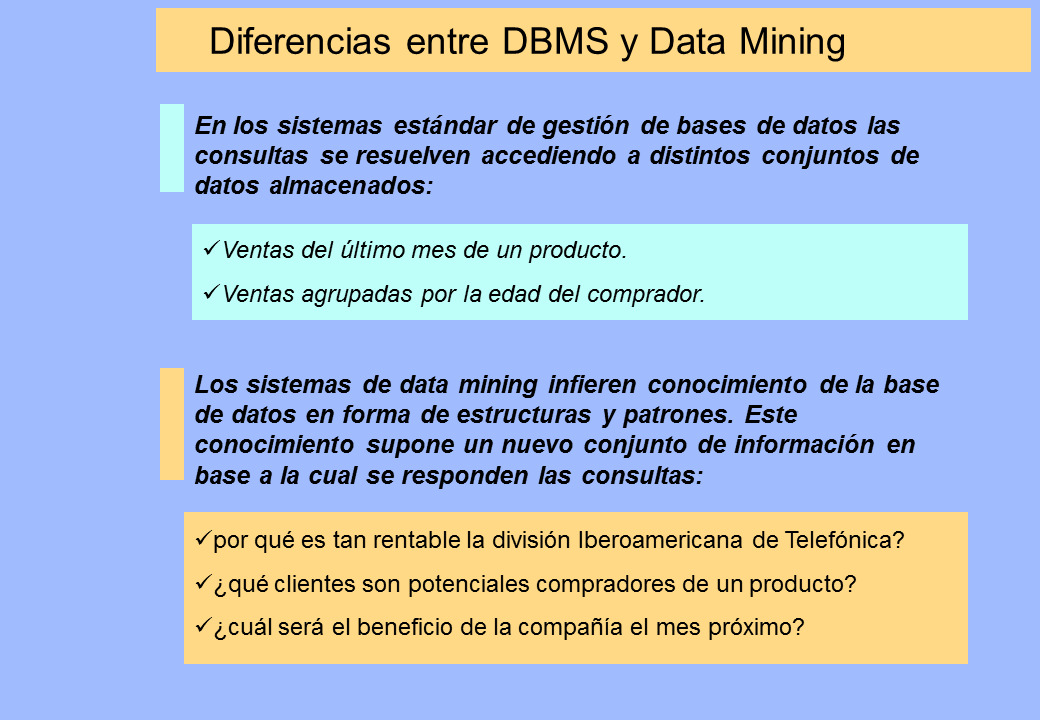

Ventas del último mes de un producto.

Ventas agrupadas por la edad del comprador.

Diferencias entre DBMS y Data Mining

por qué es tan rentable la división Iberoamericana de Telefónica?

¿qué clientes son potenciales compradores de un producto?

¿cuál será el beneficio de la compañía el mes próximo?

En los sistemas estándar de gestión de bases de datos las consultas se resuelven accediendo a distintos conjuntos de datos almacenados:

Los sistemas de data mining infieren conocimiento de la base de datos en forma de estructuras y patrones. Este conocimiento supone un nuevo conjunto de información en base a la cual se responden las consultas:

Acceso a Datos vs. Acceso a Conocimiento

Paradigma de Acceso a Datos:

El usuario solicita datos y procesa los datos recibidos en busca de "conocmiento".

Paradigma de Acceso a Conocimiento:

El sistema genera automáticamente patrones de conocimiento refinados y el usuario accede directamente a los mismos.

SQL + algoritmos de data mining.

PQL = Pattern Query Languaje

PQL was designed to access patterns just as SQL was designed to access data. PQL resembles SQL, works atop existing SQL engines.

Information Discovery uses a Pattern WarehouseTM of refined information and PQL works on patterns just as SQL works on a datawarehouse. While SQL relies on the relational algebra, PQL uses the "pattern algebra". PQL allows pattern-based queries just as SQL allows data-based queries. And, PQL uses SQL as part of its operation, i.e. PQL queries are decomposed into a set of related SQL queries, the Pattern Warehouse is accessed with these queries and the results are re-combined for display to the user. The user accesses these patterns using a web browser.

Data Mining and Business Intelligence

Increasing potential

to support

business decisions

End User

Business

Analyst

Data

Analyst

DBA

Making

Decisions

Data Presentation

Visualization Techniques

Data Mining

Information Discovery

Data Exploration

OLAP, MDA

Statistical Analysis, Querying and Reporting

Data Warehouses / Data Marts

Data Sources

Paper, Files, Information Providers, Database Systems, OLTP

Jiawei HanIntelligent Database System Research Labhttp://www.cs.sfu.ca/~han

variety of techniques to identify nuggets of information or decision-making knowledge in bodies of data, and extracting these in such a way that they can be put to use in the areas such as decision support, prediction, forecasting and estimation. The data is often voluminous, but as it stands of low value as no direct use can be made of it; it is the hidden information in the data that is useful.

Multidisciplinar. Areas y Técnicas Involucradas

Componentes Principales:

compresión de la información.

Componentes Independientes:

extracción de características.

Modelado de Dependencias:

hallar asociaciones entre variables.

redes Bayesianas

Agrupación:

hallar grupos de elementos.

Clasificación:

asignar elementos a clases.

Predicción:

estimación de valores.

Visualización:

representación gráfica.

Redes Neuronales

Areas Involucradas

Estadística y Ciencias de la Computación

Estadística

1970: EDA, estimación Bayesiana, modelos flexibles, EM, etc

Conciencia sobre el papel de la computación en el análisis de datos.

Reconocimiento de Patrones e Inteligencia Artificial

Atención dirigiga a problemas de percepción (e.g., habla, visión)

1960: división en técnicas estadísticas y no estadísticas (gramáticas, etc.)

Convergencia de estadística aplicada e ingeniería (análisis imágenes, Geman)

Aprendizaje Automático y Redes Neuronales

1980: fracaso de las téncias de aprendizaje no estadísticas

Aparición de modelos flexibles (árboles, redes)

Convergencia de estadística aplicada y aprendizaje

e.g., trabajos de Friedman, Spiegelhalter, Jordan, Hinton

IA / Apredizaje Automático

Extracción automática de conocimiento

1989 KDD workshop

ACM SIGKDD 2000

Bases de Datos

Bases de datos masivas

Reglas de asociación

Algoritmos escalables

MINERIA DE DATOS

Statistics

Computer Science

Statistical

Pattern

Recognition

Neural

Networks

Machine

Learning

Data

Mining

Databases

Statistical

Inference

Nonlinear

Regression

Pattern

Finding

Computer Vision,

Signal Recognition

Flexible

Classification

Models

Scalable

Algorithms

Graphical

Models

Hidden

Variable

Models

Focus Areas

Padhraic Smyth. Information and Computer ScienceUniversity of California, Irvine

Técnicas

Clásicas

Nuevos

Paradigmas

Inspiración Biológica

Representación explícita del conocimiento

Imitación del proceso humano de razonamiento

Procesamiento en serie de la información

sentencias lógicas,

reglas,

grafos,

redes semánticas, etc.

Inferencia lógica,

búsqueda en grafos

Inteligencia Artificial

Página siguiente  |