Pentium es una gama de microprocesadores de

arquitectura x86 desarrollados por Intel.El primer Pentium fue

lanzado el 22 de marzo de 1993 como sucesor del Intel 80486. Su

nombre clave es P54C.con velocidades iniciales de 60 y 66 MHz,

3.100.000 transistores, cache interno de 8 KB para datos y 8 KB

para instrucciones; sucediendo al procesador Intel 80486. Intel

no lo llamó 586 debido cuestiones de marketing.La

aparición de este procesador se llevó a cabo con un

movimiento económico impresionante, acabando con la

competencia, que hasta entonces producía procesadores

equivalentes, como es el 80386, el 80486 y sus variaciones o

incluso NPUs.Pentium 1 posee una arquitectura capaz de ejecutar

dos operaciones a la vez gracias a sus dos pipeline de datos de

32bits cada uno, uno equivalente al 486DX(u) y el otro

equivalente a 486SX(u). Además, poseía un bus de

datos de 64 bits, permitiendo un acceso a memoria 64 bits (aunque

el procesador seguía manteniendo compatibilidad de 32 bits

para las operaciones internas y los registros también eran

de 32 bits).

e) Pentium II

Microprocesador con arquitectura x86

diseñado por Intel, e introducido en el mercado el 7 de

mayo de 1997. Está basado en una versión modificada

del núcleo P6, usado por primera vez en el Intel Pentium

Pro.

Los cambios fundamentales respecto a éste último

fueron mejorar el rendimiento en la ejecución de

código de 16 bits, añadir el conjunto de

instrucciones MMX y eliminar la memoria caché de segundo

nivel del núcleo del procesador, colocándola en una

tarjeta de circuito impreso junto a éste.El Pentium II se

comercializó en versiones que funcionaban a una frecuencia

de reloj de entre 166 y 450 MHz. La velocidad de bus era

originalmente de 66 MHz, pero en las versiones a partir de los

333 MHz se aumentó a 100 MHz.

Poseía 32 KB de memoria caché de primer nivel

repartida en 16 KB para datos y otros 16 KB para instrucciones.

La caché de segundo nivel era de 512 KB y trabajaba a la

mitad de la frecuencia del procesador, al contrario que en el

Pentium Pro, que funcionaba a la misma frecuencia.

Como novedad respecto al resto de procesadores de la

época, el Pentium II se presentaba en un encapsulado SEC,

con forma de cartucho. El cambio de formato de encapsulado se

hizo para mejorar la disipación de calor. Este cartucho se

conecta a las placas base de los equipos mediante una ranura Slot

1.

f) Pentium III

Son unos procesadores prácticamente

iguales a los Pentium II, pero se diferencian de ellos en que

incorporan 70 nuevas instrucciones para "mejorar la experiencia

en Internet".

LAS INSTRUCCIONES

Las nuevas instrucciones se han llamado

MMX-2, para referenciarlas como una extensión de las

viejas MMX. También KNI, ya que el procesador tenía

el nombre en clave de Katmai, de ahí a las Katmai New

Instructions (KNI), aunque parece ser que también se

referencian como SSE (que no tengo ni idea de que

significa).

El porqué de estas instrucciones es

muy simple. Para mejorar la experiencia multimedia, especialmente

la decodificación de películas en DVD (para lo que

era necesario disponer de una targeta decodificadora), la

velocidad en el procesamiento de imágenes 2D y 3D,

reconocimiento de voz…. Es decir Multimedia.

Estas 70 instrucciones las podemos dividir

en 3 grupos.

En el primero podemos incluir 8 nuevas

instrucciones que mejoran el acceso a memoria (para cachear

memoria, especialmente para manejar muchos datos, como en el

reconocimiento de voz o los vectores de datos 3D).

Existen 12 nuevas instrucciones

específicas para el multimedia, para tareas como optimizar

el proceso de datos de audio o para mejorar las representaciones

MPEG2. Estas instrucciones complementan a las 59 MMX ya

existentes.

Y por último, la estrella. Las 50

nuevas instrucciones para el manejo de datos en coma flotante.

Especiamente diseñadas para el proceso de datos

tridimensionales. Estas son las más parecidas a las 3DNow!

de AMD. Pueden producir hasta 4 resultados por ciclo de reloj

(como las 3DNow!), aunque estos resultados pueden ser 4 sumas, o

4 multiplicaciones, mientras que las 3DNow! tienen que combinar

suma i multiplicación para poder cumplir con sus 4

resultados.

Además, gracias a las nuevas

instrucciones, (al igual que ocurría con las 3DNow!)

podemos utilizar el modo MMX y la unidad de coma flotante sin ver

penalizado el rendimiento (en los primeros MMX y K6, si

utilizábamos MMX no podíamos hacer operaciones en

coma flotante y al revés).

Pero como siempre, no es oro todo lo que

reluce. Según varias personas, poseedoras de un pentium

III, con la utilización de estas nuevas

instrucciones, SE PIERDE CALIDAD en la imagen. Esto se hace

más visible en los juegos 3D, donde se puede apreciar

cierto granulado en las texturas. (como ocurría al

principio con la compresión de texturas de la Savage 3D,

aunque sin llegar a esos extremos). Tal vez esto sea la

contrapartida al eumento de velocidad.

NUEVAS TECNOLOGÍAS

Pero no solo las nuevas instrucciones son

una novedad, también lo es (y es la principal ventaja) que

el procesador venga preparado para aceptar las últimas

tecnologías como pueden ser el AGPx4, la memoria Direct

Rambus o el estándar de conexión destinado a

sustituir al USB: el FireWire, así como ultra DMA 66 (que

sustituirá al ultra DMA 33 en breve) o el BUS a

133MHz.

Pero todas estas novedades tienen un

precio. Es necesario actualizar el Hardware. Los nuevos chipsets

de Intel que se llaman "Camino" y "Whitney" (gama alta, gama

baja) serán los únicos especialmente

diseñados para el nuevo procesador y los que podrán

soportar todas las nuevas características.

De momento, muchas de las placas BX del

mercado cumplen con la imprescindible característica de

soporte del BUS a 133MHz.

El porqué del BUS a 133MHz es muy

sencillo. Intel necesita un procesador potente, capaz de

plantarle cara al K7, y la única forma de hacerlo es

aumentando la velocidad del BUS (Recordemos que varios fabricntes

han presentado memorias que funcionan a 133MHz) para poder

aumentar la frecuencia del procesador. Esto es debido a que Intel

tiene problemas con la utilización de la memoria Direct

Rambus, i es la única forma que tienen de colocar un

procesador a 1GHz (133 * 8).

CARACTERÍSTICAS

Vamos a ver por encima las

características el procesador:

32 KB de caché de primer

nivel512 KB de caché de segundo

nivelBUS a 100/133MHz

70 Nuevas instrucciones

ID (del que hablaremos más

tarde)

Las características son

prácticamente idénticas a la de los Pentium II (que

pueden funcionar a 133 MHz sin problemas). Sin embargo, parece

ser que la caché de segundo nivel es un poco más

lenta para permitir velocidades superiores del

procesador.

RENDIMIENTO

Según la propia Intel, comparando un

procesador Pentium II 450 con un pentium III 450 podemos

obener un aumento de rendimiento de un 74%, siempre que se trate

de aplicaciones especialmente diseñadas para el pentium

III, esa diferencia aumenta a un 93% si se trata de un

pentium III a 500.

También AMD ha comparado su nuevo

K6-III con el pentium III dando estos

resultados:

Estos resultados los obtenemos sin ninguna

optimización por parte de ninguno de los 2 procesadores.

Observamos como el rendimiento del K6-III en entornos de trabajo

Windows es espectacular, mientras que los pentium III,

no funcionan más rápido que los pentium II, como

podeis observar aquí:

El aumento de rendimiento sin las nuevas

instrucciones se debe únicamente a la velocidad a la que

trabaja el procesador. El incremento de rendimiento de un

pentiumIII 500 frente a un Pentium II 450 es de un 3'18%. (el

aumento de rendimiento de un Pentium II 400 a un 450 es de un

3'8%, bastante similar, solo aumentando 50MHz).

La principal novedad es la inclusión

de las nuevas instruciones, que son la única forma de

aumentar el rendimiento.

g) Pentium 4

El Pentium 4 es un microprocesador basado en la

arquitectura x86 y fabricado por Intel. Es el primer

microprocesador con un diseño completamente nuevo desde el

Pentium Pro de 1995. El Pentium 4 original, denominado

Willamette, trabajaba a 1,4 y 1,5 GHz; y fue lanzado el 20 de

noviembre de 2000.[1] El 8 de agosto de 2008 se realiza el

último envío de Pentium 4,[2] siendo sustituido por

los Intel Core Duo

Para la sorpresa de la industria informática, la nueva

microarquitectura NetBurst del Pentium 4 no mejoró el

viejo diseño de la microarquitectura Intel P6 según

las dos tradicionales formas para medir el rendimiento: velocidad

en el proceso de enteros u operaciones de punto flotante. La

estrategia de Intel fue sacrificar el rendimiento de cada ciclo

para obtener a cambio mayor cantidad de ciclos por segundo y una

mejora en las instrucciones SSE. En 2004, se agregó el

conjunto de instrucciones x86-64 de 64 bits al tradicional set

x86 de 32 bits. Al igual que los Pentium II y Pentium III, el

Pentium 4 se comercializa en una versión para equipos de

bajo presupuesto (Celeron), y una orientada a servidores de gama

alta (Xeon).

Las nombres en código, a partir de la evolución

de las distintas versiones, son: Willamette (180

nanómetros), Northwood (130 nm), Gallatin (Extreme

Edition, también 130 nm), Prescott (90 nm) y Cedar Mill

(65 nm).

Las distintas versiones

Willamette

Willamette, la primera versión del Pentium 4,

sufrió de importantes demoras durante el diseño. De

hecho, muchos expertos aseguran que los primeros modelos de

1,3 ; 1,4 y 1,5 GHz fueron lanzados prematuramente para

evitar que se extienda demasiado el lapso de demora de los

Pentium 4. Además, los modelos más nuevos del AMD

Thunderbird tenían un rendimiento superior al Intel

Pentium III, pero la línea de producción se

encontraba al límite de su capacidad por el momento.

Fueron fabricados utilizando un proceso de 180 nm y utilizaban el

Socket 423 para conectarse a la placa base.

A la hora de los exámenes de rendimiento, los

Willamette fueron una decepción ya que no podían

superar claramente a los Thunderbird ni a los Pentium III de

mayor velocidad. Incluso la diferencia con la línea de

bajo costo AMD Duron no era significante. Vendió una

cantidad moderada de unidades.

En enero de 2001 un microprocesador más lento de 1,3

GHz fue añadido a la lista. En la primera mitad del mismo

año, salieron a la venta los modelos de 1,6, 1,7 y 1,8 GHz

notablemente superiores a los Pentium III. En agosto, los modelos

de 1,9 y 2,0 GHz vieron la luz (todavía con la inicial

tecnología de proceso de 0,18 micrones o 180

nanómetros).

El Willamette de 2,0 GHz fue el primer Pentium 4 que puso en

duda el liderazgo en rendimiento, que hasta ese momento estaba

liderado indiscutiblemente por la línea Thunderbird de

AMD. Si bien algunos resultados arrojaban una leve diferencia a

favor de AMD, los analistas concluyeron que la diferencia no era

significativa para decir que un procesador era claramente

superior al otro. Y salieron las primeras Placas con socket 478 y

nucleo Willamette. Esto fue un gran paso para Intel, que hasta la

salida del AMD Athlon había sido el rey de la velocidad en

los microprocesadores por 16 años en forma casi

ininterrumpida.

Northwood

En octubre de 2001, el Athlon XP reconquistó el

liderazgo en la velocidad de los procesadores, pero en enero de

2002 Intel lanzó al mercado los nuevos Northwood de 2,0 y

2,2 GHz. Esta nueva versión combina un incremento de 256 a

512 KB en la memoria caché con la transición a la

tecnología de producción de 130 nanómetros.

Al estar el microprocesador compuesto por transistores más

pequeños, podía alcanzar mayores velocidades y a la

vez consumir menos energía. El nuevo procesador funcionaba

con el Socket 478, el cual se había visto en los

últimos modelos de la serie Willamette.

Con la serie Northwood, los Pentium 4 alcanzaron su madurez.

La lucha por la cima del rendimiento se mantuvo reñida, a

medida que AMD introducía versiones más veloces del

Athlon XP. Sin embargo, la mayoría de los observadores

concluyeron que el Northwood más veloz siempre estaba

ligeramente por encima de los modelos de AMD. Esto se hizo

notorio cuando el paso de AMD a la manufactura de 130 nm fue

postergada.

Un Pentium 4 de 2,4 GHz fue introducido en abril de 2002, uno

de 2,53 GHz en mayo (cuya principal optimización fue que

incluyó un aumento del FSB de 100 a 133 MHz QDR, es decir,

de 400 a 533 MHz efectivos). En agosto vieron la luz los modelos

de 2,6 y 2,8 GHz, y en noviembre la versión de 3,06 GHz

(23×133 MHz QDR). Este último además soporta

HyperThreading, una tecnología originalmente aparecida en

los Intel Xeon que permite al sistema operativo trabajar con dos

procesadores lógicos (lo que, en ciertas condiciones

específicas, permite aproximarse al rendimiento

proporcionado por dos CPUs físicas propiamente dichas, o

por las actuales de doble núcleo).

En abril de 2003, Intel colocó en el mercado nuevas

variantes, entre los 2,4 y 3,0 GHz, cuya principal diferencia era

que todos ellos incluían la tecnología

HyperThreading y el FSB era de 800 MHz(200 MHz QDR).

Supuestamente esto era para competir con la línea Hammer

de AMD, pero inicialmente sólo salió a la luz la

serie Opteron, la cual no estaba destinada entonces a competir

directamente contra los Pentium 4 (debido a que los primeros

estaban dedicados al mercado corporativo, mientras que el segundo

al consumidor final). Por otro lado, los AMD Athlon XP, a pesar

de su FSB aumentado de 333 a 400 MHz y las velocidades más

altas no pudieron alcanzar a los nuevos Pentium 4 de 3,0 y 3,2

GHz. La versión final de los Northwood, de 3,4 GHz, fue

introducida a principios de 2004.

Gallatin (Extreme

Edition)

En septiembre de 2003, Intel anunció

la edición extrema (Extreme Edition) del Pentium

4, apenas sobre una semana antes del lanzamiento del Athlon 64, y

el Athlon 64 FX. El motivo del lanzamiento fue porque AMD

alcanzó en velocidad de nuevo a Intel, por ello fueron

apodados Emergency Edition. El diseño era idéntico

al Pentium 4 (hasta el punto de que funcionaría en las

mismas placas base), pero se diferenciaba por tener 2 MB

adicionales de memoria caché L3. Compartió la misma

tecnología Gallatin del Xeon MP, aunque con un Socket 478

(a diferencia del Socket 603 de los Xeon MP) y poseía un

FSB de 800MHz, dos veces más grande que el del Xeon MP.

Una versión para Socket LGA775 también fue

producida.

Mientras que Intel mantuvo que la Extreme

Edition estaba apuntada a los jugadores de videojuegos, algunos

tomaron esta nueva versión como un intento de desviar la

atención del lanzamiento de los AMD Athlon 64. Otros

criticaron a Intel por mezclar la línea Xeon

(especialmente orientada a servidores) con sus procesadores para

usuarios individuales, pero poco se criticó cuando AMD

hizo lo mismo con el Athlon 64 FX.

El efecto de la memoria adicional tuvo

resultados variados. En las aplicaciones de ofimática, la

demora ocasionada por el mayor tamaño de la memoria

caché hacía que los Extreme Edition fuesen menos

veloces que los Northwood. Sin embargo, el área donde se

destacó fue en la codificación multimedia, que

superaba con creces a la velocidad de los anteriores Pentium 4 y

a toda la línea de AMD. Poseen una velocidad de reloj de

3,73 GHz.

Prescott

A principios de febrero de 2004, Intel

introdujo una nueva versión de Pentium 4 denominada

'Prescott'. Primero se utilizó en su manufactura un

proceso de fabricación de 90 nm y luego se cambió a

65nm; además se hicieron significativos cambios en la

microarquitectura del microprocesador, por lo cual muchos

pensaron que Intel lo promocionaría como Pentium 5. A

pesar de que un Prescott funcionando a la misma velocidad que un

Northwood rinde menos, la renovada arquitectura del Prescott

permite alcanzar mayores velocidades y el overclock es más

viable. El modelo de 3,8 GHz(Solo para LGA775) es el más

veloz de los que hasta ahora han entrado en el

mercado.

Su diferencia con los anteriores es que

éstos poseen 1 MB o 2 MB de caché L2 y 16 KB de

caché L1 (el doble que los Northwood), Prevención

de Ejecución, SpeedStep, C1E State, un HyperThreading

mejorado, instrucciones SSE3, manejo de 64 bits, también

recibió unas mejoras en el sistema de predicción de

datos, y tiene un pipeline de 31 etapas, que por cierto, fue unos

de los mayores errores de dicho núcleo. Además, los

primeros Prescott producían un 60% más de calor que

un Northwood a la misma velocidad, y por ese motivo muchos lo

criticaron con dureza. Se experimentó con un cambio en el

tipo de zócalo (de Socket 478 a LGA 775) lo cual

incrementó en un 10% el consumo de energía del

microprocesador, pero al ser más efectivo el sistema de

refrigeración de este zócalo, la temperatura final

bajó algunos grados. En posteriores revisiones del

procesador los ingenieros de Intel esperaban reducir las

temperaturas, pero esto nunca ocurrió fuera salvo a bajas

velocidades. El procesador genera unos 130 W de calor, o TDP.

Finalmente, los problemas térmicos fueron tan severos,

que Intel decidió abandonar la arquitectura Prescott por

completo, y los intentos de hacer correr por encima de los 4 GHz

fueron abandonados, como un gasto inútil de recursos

internos. También lo concerniente a las críticas

mostradas en casos extremos de llevar al procesador Prescott a

los 5,2 GHz para emparejarlo al Athlon FX-55 que funcionaba a

2,6GHz.[3] Considerando una fanfarronada de Intel el lanzamiento

de la arquitectura Pentium 4 diseñada para operar a 10

GHz, esto puede ser visto como uno de los más

significativos, ciertamente el más público,

déficit de ingeniería en la historia de Intel.

Según se dice el Pentium M es ahora la referencia

interna para el equipo diseñadores de Intel, y el

desarrollo del P4 ha sido esencialmente abandonado. Hasta este

punto el pequeño equipo de diseño Israelí

que produce el Pentium M, tiene ahora que tomar otro proyecto

mucho más grande.

¿Por qué el fin de Prescott ha terminado en tal

desastre? Puede ser atribuido a las políticas internas de

Intel. El departamento de mercadotecnia quería siempre

velocidades de procesador más altas, para diferenciar sus

productos de AMD. Los procesadores se diseñaban por las

necesidades de mercadeo, en vez de las necesidades de la

arquitectura. Fueron carreras construidas sobre el concepto de la

velocidad del procesador, la terminación del proyecto P4

finalmente vino y tuvo consecuencias para muchos miembros del

equipo de dirección de la división.

Los Prescott con Socket LGA775 usan el nuevo sistema de

puntaje, y están clasificados en la serie 5XX. El

más rápido es el 570J, lanzado a comienzos de 2005

y que funciona a 3,8 GHz. Los planes para microprocesadores de 4

o más GHz fueron cancelados y se les dio prioridad a los

proyectos para fabricar procesadores dobles; en gran medida

debido a los problemas de consumo energía y

producción de calor de los modelos Prescott. El procesador

570J también fue el primero en introducir la

tecnología EDB, la cual es idéntica a la más

temprana NX de AMD. El objetivo es prevenir la ejecución

de algunos tipos de código maligno.

Doble procesador

Intel tiene planeadas cuatro variantes con

doble procesador del Pentium 4. La primera es denominada

Paxville, que consiste en poco más que dos procesadores

Prescott colocados en el mismo substrato. Le seguirá,

situándose el más básico de los Core2 Duo

(E6300, 1,86 GHz) por encima del más potente de los

Pentium D (965 EE, 3,73 GHz, 14×133 MHz QDR). Esto se debe a que

la microarquitectura Core 2 Duo es muy eficiente, realiza hasta

un 80% más trabajo por ciclo del reloj que la

antigua arquitectura NetBurst de los Pentium 4, superando en ese

indicador incluso al K8 (Athlon 64) de AMD por un margen de entre

el 20-25%.

DualCore y QuadCore

A principios de 2006, Intel presentó

sus últimos procesadores orientados a negocios,

diseño y juegos, con procesadores de dos y cuatro

núcleos y velocidades de 1,7; 1,8; 2,1; 2,4; 2,5; 2,66;

2,83; 3,0 y 3,2 GHz. Aunque los precios del procesador de 4

núcleos (QuadCore) aún son muy altos, es la muestra

clara de que Intel seguirá en el futuro incrementando los

núcleos del procesador para aumentar velocidad y

rendimiento multimedia. En mayo de 2007, mediante

televisión vía satélite, Intel

presentó un equipo que incluía un procesador de 8

núcleos que, según los informantes del evento, es

el prototipo de los procesadores Intel para 2010.

3.- Describa las generaciones de

desarrollo de computadoras

PRIMERA GENERACIÓN (1951 a

1958)

Las computadoras de la primera

Generación emplearon bulbos para procesar

información. Los operadores ingresaban los datos

y programas en

código especial por medio de tarjetas

perforadas. El almacenamiento interno se lograba con un tambor

que giraba rápidamente, sobre el cual un dispositivo de

lectura/escritura

colocaba marcas

magnéticas. Esas computadoras de bulbos eran mucho

más grandes y generaban más calor que los modelos

contemporáneos.

Eckert y Mauchly contribuyeron al

desarrollo de computadoras de la 1era Generación formando

una compañía privada y construyendo UNIVAC I, que

el Comité del censo utilizó para evaluar el censo

de 1950. La IBM tenía el monopolio de los equipos de

procesamiento de datos a base de tarjetas perforadas y estaba

teniendo un gran auge en productos como rebanadores de carne,

básculas para comestibles, relojes y otros

artículos; sin embargo no había logrado el contrato

para el Censo de 1950.

Comenzó entonces a construir computadoras

electrónicas y su primera entrada fue con la IBM 701 en

1953. Después de un lento pero exitante comienzo la IBM

701 se conviertió en un producto comercialmente viable.

Sin embargo en 1954 fue introducido el modelo IBM 650, el cual es

la razón por la que IBM disfruta hoy de una gran parte del

mercado de las computadoras. La administración de la IBM

asumió un gran riesgo y estimó una venta de 50

computadoras. Este número era mayor que la cantidad de

computadoras instaladas en esa época en E.U. De hecho la

IBM instaló 1000 computadoras. El resto es historia.

Aunque caras y de uso limitado las computadoras fueron aceptadas

rápidamente por las Compañias privadas y de

Gobierno. A la mitad de los años 50 IBM y Remington Rand

se consolidaban como líderes en la fabricación de

computadoras.

SEGUNDA GENERACIÓN (1959-1964)

Transistor Compatibilidad Limitada

El invento del transistor hizo posible una nueva

Generación de computadoras, más rápidas,

más pequeñas y con menores necesidades de

ventilación. Sin embargo el costo seguía siendo una

porción significativa del presupuesto de una

Compañía. Las computadoras de la segunda

generación también utilizaban redes de

núcleos magnéticos en lugar de tambores giratorios

para el almacenamiento primario. Estos núcleos

contenían pequeños anillos de material

magnético, enlazados entre sí, en los cuales

podían almacenarse datos e instrucciones.

Los programas de computadoras también

mejoraron. El COBOL (COmmon Busines Oriented Languaje)

desarrollado durante la 1era generación estaba ya

disponible comercialmente, este representa uno de os mas grandes

avances en cuanto a portabilidad de programas entre diferentes

computadoras; es decir, es uno de los primeros programas que se

pueden ejecutar en diversos equipos de computo después de

un sencillo procesamiento de compilación. Los programas

escritos para una computadora podían transferirse a otra

con un mínimo esfuerzo. Grace Murria Hooper (1906-1992),

quien en 1952 habia inventado el primer compilador fue una de las

principales figuras de CODASYL (Comité on Data SYstems

Languages), que se encago de desarrollar el proyecto COBOL El

escribir un programa ya no requería entender plenamente el

hardware de la computación. Las computadoras de la 2da

Generación eran sustancialmente más pequeñas

y rápidas que las de bulbos, y se usaban para nuevas

aplicaciones, como en los sistemas para reservación en

líneas aéreas, control de tráfico

aéreo y simulaciones para uso general. Las empresas

comenzaron a aplicar las computadoras a tareas de almacenamiento

de registros, como manejo de inventarios, nómina y

contabilidad.

La marina de E.U. utilizó las computadoras de la

Segunda Generación para crear el primer simulador de

vuelo. (Whirlwind I). HoneyWell se colocó como el primer

competidor durante la segunda generación de computadoras.

Burroughs, Univac, NCR, CDC, HoneyWell, los más grandes

competidores de IBM durante los 60s se conocieron como el grupo

BUNCH.

Algunas de las computadoras que se construyeron ya con

transistores fueron la IBM 1401, las Honeywell 800 y su serie

5000, UNIVAC M460, las IBM 7090 y 7094, NCR 315, las RCA 501 y

601, Control Data Corporation con su conocido modelo CDC16O4, y

muchas otras, que constituían un mercado de gran

competencia, en rápido crecimiento. En esta

generación se construyen las supercomputadoras Remington

Rand UNIVAC LARC, e IBM Stretch (1961).

TERCERA GENERACIÓN

(1964-1971)

Circuitos Integrados, Compatibilidad con

Equipo Mayor, Multiprogramación, Minicomputadora

.

Las computadoras de la tercera

generación emergieron con el desarrollo de los circuitos

integrados (pastillas de silicio) en las cuales se colocan miles

de componentes electrónicos, en una integración en

miniatura. Las computadoras nuevamente se hicieron más

pequeñas, más rápidas, desprendían

menos calor y eran energéticamente más

eficientes.

El descubrimiento en 1958 del primer

Circuito Integrado (Chip) por el ingeniero Jack S. Kilby (nacido

en 1928) de Texas Instruments, así como los trabajos que

realizaba, por su parte, el Dr. Robert Noyce de Fairchild Semicon

ductors, acerca de los circuitos integrados, dieron origen a la

tercera generación de computadoras.

Antes del advenimiento de los circuitos

integrados, las computadoras estaban diseñadas para

aplicaciones matemáticas o de negocios, pero no para las

dos cosas. Los circuitos integrados permitieron a los fabricantes

de computadoras incrementar la flexibilidad de los programas, y

estandarizar sus modelos.

La IBM 360 una de las primeras computadoras

comerciales que usó circuitos integrados, podía

realizar tanto análisis numéricos como

administración ó procesamiento de archivos.

IBM marca el inicio de esta generación,

cuando el 7 de abril de 1964 presenta la impresionante IBM 360,

con su tecnología SLT (Solid Logic Technology). Esta

máquina causó tal impacto en el mundo de la

computación que se fabricaron más de 30000, al

grado que IBM llegó a conocerse como sinónimo de

computación.

También en ese año, Control Data Corporation

presenta la supercomputadora CDC 6600, que se consideró

como la más poderosa de las computadoras de la

época, ya que tenía la capacidad de ejecutar unos 3

000 000 de instrucciones por segundo (mips).

Se empiezan a utilizar los medios magnéticos de

almacenamiento, como cintas magnéticas de 9 canales,

enormes discos rígidos, etc. Algunos sistemas

todavía usan las tarjetas perforadas para la entrada de

datos, pero las lectoras de tarjetas ya alcanzan velocidades

respetables.

Los clientes podían escalar sus sistemas 360 a modelos

IBM de mayor tamaño y podían todavía correr

sus programas actuales. Las computadoras trabajaban a tal

velocidad que proporcionaban la capacidad de correr más de

un programa de manera simultánea

(multiprogramación).

Por ejemplo la computadora podía estar calculando la

nomina y aceptando pedidos al mismo tiempo. Minicomputadoras, Con

la introducción del modelo 360 IBM acaparó el 70%

del mercado, para evitar competir directamente con IBM la empresa

Digital Equipment Corporation DEC redirigió sus esfuerzos

hacia computadoras pequeñas. Mucho menos costosas de

comprar y de operar que las computadoras grandes, las

minicomputadoras se desarrollaron durante la segunda

generación pero alcanzaron sumador auge entre 1960 y

70.

CUARTA GENERACIÓN (1971 a

1981)

Microprocesador , Chips de

memoria, Microminiaturización

Dos mejoras en la tecnología de las

computadoras marcan el inicio de la cuarta generación: el

reemplazo de las memorias con núcleos magnéticos,

por las de chips de silicio y la colocación de Muchos

más componentes en un Chip: producto de la

microminiaturización de los circuitos electrónicos.

El tamaño reducido del microprocesador y de chips hizo

posible la creación de las computadoras personales

(PC)

En 1971, intel Corporation, que era una pequeña

compañía fabricante de semiconductores ubicada en

Silicon Valley, presenta el primer microprocesador o Chip de 4

bits, que en un espacio de aproximadamente 4 x 5 mm

contenía 2 250 transistores. Este primer microprocesador

que se muestra en la figura 1.14, fue bautizado como el 4004.

Silicon Valley (Valle del Silicio) era una región

agrícola al sur de la bahía de San Francisco, que

por su gran producción de silicio, a partir de 1960 se

convierte en una zona totalmente industrializada donde se asienta

una gran cantidad de empresas fabricantes de semiconductores y

microprocesadores. Actualmente es conocida en todo el mundo como

la región más importante para las industrias

relativas a la computación: creación de programas y

fabricación de componentes.

Actualmente ha surgido una enorme cantidad de fabricantes de

microcomputadoras o computadoras personales, que utilizando

diferentes estructuras o arquitecturas se pelean literalmente por

el mercado de la computación, el cual ha llegado a crecer

tanto que es uno de los más grandes a nivel mundial; sobre

todo, a partir de 1990, cuando se logran sorprendentes avances en

Internet.

Esta generación de computadoras se caracterizó

por grandes avances tecnológicos realizados en un tiempo

muy corto. En 1977 aparecen las primeras microcomputadoras, entre

las cuales, las más famosas fueron las fabricadas por

Apple Computer, Radio Shack y Commodore Busíness Machines.

IBM se integra al mercado de las microcomputadoras con su

Personal Computer (figura 1.15), de donde les ha quedado como

sinónimo el nombre de PC, y lo más importante; se

incluye un sistema operativo estandarizado, el MS- DOS (MicroSoft

Disk Operating System).

Las principales tecnologías que dominan este mercado

son:

IBM y sus compatibles llamadas clones, fabricadas por

infinidad de compañías con base en los procesadores

8088, 8086, 80286, 80386, 80486, 80586 o Pentium, Pentium II,

Pentium III y Celeron de Intel y en segundo término Apple

Computer, con sus Macintosh y las Power Macintosh, que tienen

gran capacidad de generación de gráficos y sonidos

gracias a sus poderosos procesadores Motorola serie 68000 y

PowerPC, respectivamente. Este último microprocesador ha

sido fabricado utilizando la tecnología RISC (Reduced

Instruc tion Set Computing), por Apple Computer Inc., Motorola

Inc. e IBM Corporation, conjuntamente.

Los sistemas operativos han alcanzado un notable desarrollo,

sobre todo por la posibilidad de generar gráficos a gran

des velocidades, lo cual permite utilizar las interfaces

gráficas de usuario (Graphic User Interface, GUI), que son

pantallas con ventanas, iconos (figuras) y menús

desplegables que facilitan las tareas de comunicación

entre el usuario y la computadora, tales como la selección

de comandos del sistema operativo para realizar operaciones de

copiado o formato con una simple pulsación de cualquier

botón del ratón (mouse) sobre uno de los iconos o

menús.

QUINTA GENERACIÓN Y LA INTELIGENCIA ARTIFICIAL

(1982-1989)

Cada vez se hace más difícil la

identificación de las generaciones de computadoras, porque

los grandes avances y nuevos descubrimientos ya no nos sorprenden

como sucedió a mediados del siglo XX. Hay quienes

consideran que la cuarta y quinta generación han

terminado, y las ubican entre los años 1971-1984 la

cuarta, y entre 1984-1990 la quinta. Ellos consideran que la

sexta generación está en desarrollo desde 1990

hasta la fecha.

Siguiendo la pista a los acontecimientos tecnológicos

en materia de computación e informática, podemos

puntualizar algunas fechas y características de lo que

podría ser la quinta generación de

computadoras.

Con base en los grandes acontecimientos tecnológicos en

materia de microelectrónica y computación

(software) como CADI CAM, CAE, CASE, inteligencia artificial,

sistemas expertos, redes neuronales, teoría del caos,

algoritmos genéticos, fibras ópticas,

telecomunicaciones, etc., a de la década de los

años ochenta se establecieron las bases de lo que se puede

conocer como quinta generación de computadoras.

Hay que mencionar dos grandes avances tecnológicos, que

sirvan como parámetro para el inicio de dicha

generación: la creación en 1982 de la primera

supercomputadora con capacidad de proceso paralelo,

diseñada por Seymouy Cray, quien ya experimentaba desde

1968 con supercomputadoras, y que funda en 1976 la Cray Research

Inc.; y el anuncio por parte del gobierno japonés del

proyecto "quinta generación", que según se

estableció en el acuerdo con seis de las más

grandes empresas japonesas de computación, debería

terminar en 1992.

El proceso paralelo es aquél que se lleva a cabo en

computadoras que tienen la capacidad de trabajar

simultáneamente con varios microprocesadores. Aunque en

teoría el trabajo con varios microprocesadores

debería ser mucho más rápido, es necesario

llevar a cabo una programación especial que permita

asignar diferentes tareas de un mismo proceso a los diversos

microprocesadores que intervienen.

También se debe adecuar la memoria para que pueda

atender los requerimientos de los procesadores al mismo tiempo.

Para solucionar este problema se tuvieron que diseñar

módulos de memoria compartida capaces de asignar

áreas de caché para cada procesador.

Según este proyecto, al que se sumaron los

países tecnológicamente más avanzados para

no quedar atrás de Japón, la característica

principal sería la aplicación de la inteligencia

artificial (Al, Artificial Intelligence). Las computadoras de

esta generación contienen una gran cantidad de

microprocesadores trabajando en paralelo y pueden reconocer voz e

imágenes. También tienen la capacidad de

comunicarse con un lenguaje natural e irán adquiriendo la

habilidad para tomar decisiones con base en procesos de

aprendizaje fundamentados en sistemas expertos e inteligencia

artificial.

El almacenamiento de información se realiza en

dispositivos magneto ópticos con capacidades de decenas de

Gigabytes; se establece el DVD (Digital Video Disk o Digital

Versatile Disk) como estándar para el almacenamiento de

video y sonido; la capacidad de almacenamiento de datos crece de

manera exponencial posibilitando guardar más

información en una de estas unidades, que toda la que

había en la Biblioteca de Alejandría. Los

componentes de los microprocesadores actuales utilizan

tecnologías de alta y ultra integración,

denominadas VLSI (Very Large Sca/e Integration) y ULSI (Ultra

Lar- ge Scale Integration).

Sin embargo, independientemente de estos

"milagros" de la tecnología moderna, no se distingue la

brecha donde finaliza la quinta y comienza la sexta

generación.

Personalmente, no hemos visto la

realización cabal de lo expuesto en el proyecto

japonés debido al fracaso, quizás

momentáneo, de la inteligencia artificial.El único

pronóstico que se ha venido realizando sin interrupciones

en el transcurso de esta generación, es la conectividad

entre computadoras, que a partir de 1994, con el advenimiento de

la red Internet y del World Wide Web, ha adquirido una

importancia vital en las grandes, medianas y pequeñas

empresas y, entre los usuarios particulares de

computadoras.

El propósito de la

Inteligencia Artificial es equipar a las Computadoras con

"Inteligencia Humana" y con la capacidad de razonar para

encontrar soluciones. Otro factor fundamental del

diseño, la capacidad de la Computadora para reconocer

patrones y secuencias de procesamiento que haya encontrado

previamente, (programación Heurística) que permita

a la Computadora recordar resultados previos e incluirlos en el

procesamiento, en esencia, la Computadora aprenderá a

partir de sus propias experiencias usará sus Datos

originales para obtener la respuesta por medio del razonamiento y

conservará esos resultados para posteriores tareas de

procesamiento y toma de decisiones.

SEXTA GENERACIÓN 1990 HASTA LA

FECHA

Como supuestamente la sexta

generación de computadoras está en marcha desde

principios de los años noventas, debemos por lo menos,

esbozar las características que deben tener las

computadoras de esta generación. También se

mencionan algunos de los avances tecnológicos de la

última década del siglo XX y lo que se espera

lograr en el siglo XXI. Las computadoras de esta

generación cuentan con arquitecturas combinadas Paralelo /

Vectorial, con cientos de microprocesadores vectoriales

trabajando al mismo tiempo; se han creado computadoras capaces de

realizar más de un millón de millones de

operaciones aritméticas de punto flotante por segundo

(teraflops); las redes de área mundial (Wide Area Network,

WAN) seguirán creciendo desorbitadamente utilizando medios

de comunicación a través de fibras ópticas y

satélites, con anchos de banda impresionantes. Las

tecnologías de esta generación ya han sido

desarrolla das o están en ese proceso. Algunas de ellas

son: inteligencia / artificial distribuida; teoría del

caos, sistemas difusos, holografía, transistores

ópticos, etcétera.

En esta

investigación acerca de las generaciones de las

computadoras nos hemos dado cuenta del avance que han tenidos y ,

gracias a los avances en relación a ellas hemos alcanzado

un nivel de tecnología muy elevado el cual nos ha servido

para muchas áreas, como por ejemplo las comunicaciones, la

medicina, la educación, etc.

La investigación actual va dirigida

a aumentar la velocidad y capacidad de las computadoras se centra

sobre todo en la mejora de la tecnología de los circuitos

integrados y en el desarrollo de componentes de

conmutación aún más rápidos. Se han

construido circuitos integrados a gran escala que contienen

varios millones de componentes en un solo chip.

Las computadoras se han convertido en la

principal herramienta utilizada por el hombre y ya son parte

esencial de cada uno de nosotros, y usted deberá aprender

todas esas, antes complicadas hoy comunes tecnologías

modernas

Desarrollo por

componentes

1.- Desarrolle y describa con un grafico

los tipos de case siguientes

Tipo AT.- Esta prácticamente

en desuso, trae 2 conectores llamados P8 y P9 que Alimentan a la

mother board

a) Case en torre

Descripción: es vertical y alta,

con 7 alojamientos, 4 de 5 ¼" y 3 de 3 ½" es el

más grande.Ventajas: permite que se distribuya

mejor el calor. El acceso a los componentes se facilita y

tiene muy buenas capacidades de crecimiento.Desventajas: suele ser el tipo de caja

más costoso, su gran tamaño puede dificultar

acomodarlo facilmente en nuestros escritorios.

b) Case Tipo Mini Torre

Descripción: es vertical y

pequeña, tiene 2 ó 3 cavidades o alojamientos de 5

¼ pulgadas y 2 de 3 ½ pulgadas, podría

alojar 4 o 5 dispositivos internos.

Ventajas: más económica y

facil de acomodar en cualquier escritorio ú oficina.

Desventajas: su capacidad de acceso y crecimiento es más

limitado.

c) Case Tipo BabyTorre

Es vertical y aun mas pequeña posee

cavidades de alojamiento de de 5 ¼ pulgadas y 2 de 3

½ pulgadas

Ventajas: más económica y

fácil de acomodar en cualquier escritorio ú

oficina.

Desventajas: no solo su capacidad de acceso

y crecimiento es más limitado si no que esto hace que

exista menor ventilación en los componentes

internos

Tipo ATX:

Case full tower

Case médium tower

Case Estándar

2. Desarrolle las características

principales de una fuente de poder

a) Voltajes de entrada

La fuente de poder se caracteriza por tener un

voltaje de entrada de 220wtts. Y 110 wtts normalmente, pero

como los fabricantes siguen lanzando al mercado de mejor

calidad comenzaron a fabricar de 220wtts, 300wtts, 400wtts,

500wtts,…etc. Eso debido al tiempo de uso y el tiempo de

duración de la misma fuente de poder y así dar

la comodidad a los proveedores que ellos llegarían a

ser los mas beneficiados, pero también por otro lado

la empresa que brinda este servicio de energía

eléctrica tiene algunos problemas como ser que en

ocasiones puede llegar a tener altas tenciones como bajas

tenciones, pero normalmente el voltaje que nos provee la

empresa es de 220wts.

b) Voltajes de salida

Los voltajes de Salida de la fuente de poder se

regulan dentro de ella, para de esa manera Los cables de

poder puedan transportan la electricidad hacia cada

componente de hardware de las PCs. Los que irán

conectados a sus unidades de discos y a algunos ventiladores

son grupos de cuatro cables sencillos (uno amarillo, uno rojo

y dos negros en el centro) con el mismo conector. Observe el

significado de cada color en la siguiente tabla:

Wats <=200, <=300, <=400,

otrosLos voltajes nos llegarían a

indicar el tiempo que tuviera que estar encendido y estos

pueden ser de la siguiente manera:

200wtts y 300wtts: de 4-6 horas de

uso400wtts y 500wtts: de 6 – 8 horas

de uso600wtts: de 8-12 horas

3.- Describa con un grafico las

características el uso y las características en

las tarjetas madre por:a) Socket.-

Es el lugar donde se inserta el "cerebro" del

ordenador. Durante más de 10 años ha consistido

en un rectángulo o cuadrado donde el "micro", una

pastilla de plástico negro con patitas, se

introducía con mayor o menor facilidad; recientemente,

la aparición de los Pentium II ha cambiado un poco

este panorama y así para mas adelante según la

exigencia sea mas del usuario.Veamos en detalle los tipos más comunes de

zócalo, o socket, como dicen los

anglosajones:PGA: son el modelo clásico, usado en el 386 y

el 486; consiste en un cuadrado de conectores en forma de

agujero donde se insertan las patitas del chip por pura

presión. Según el chip, tiene más o

menos agujeritos.ZIF: Zero Insertion Force (socket), es decir,

zócalo de fuerza de inserción nula. El gran

avance que relajó la vida de los manazas aficionados a

la ampliación de ordenadores. Eléctricamente es

como un PGA, aunque gracias a un sistema mecánico

permite introducir el micro sin necesidad de fuerza alguna,

con lo que el peligro de cargarnos el chip por romperle una

patita desaparece.Apareció en la época del 486 y sus

distintas versiones (sockets 3, 5 y 7, principalmente) se han

utilizado hasta que apareció el Pentium II.

Actualmente se fabrican tres tipos de zócalos

ZIF:Socket 7 "Súper 7": variante del Socket 7 que

se caracteriza por poder usar velocidades de bus de hasta 100

MHz, es el que utilizan los micros AMD K6-2.Socket 370 o PGA370: físicamente similar al

anterior, pero incompatible con él por utilizar un bus

distinto. Dos versiones: PPGA (la más antigua,

sólo para micros Intel Celeron Mendocino) y FC-PGA

(para Celeron y los más recientes Pentium

III).Socket A: utilizado únicamente por los

más recientes AMD K7 Athlon y por los AMD Duron. El

478: utilizado únicamente por los más recientes

Intel P IV

b) Slot.-

Son unas ranuras de plástico con conectores

eléctricos (slots) donde se introducen las tarjetas de

expansión (tarjeta de vídeo, de sonido, de

red…). Según la tecnología en que se basen

presentan un aspecto externo diferente, con diferente

tamaño y a veces incluso en distinto color.4.- Describa con un grafico las

características y la función que cumplen los

SlotsSlots ISA: son las más veteranas, un

legado de los primeros tiempos del PC. Funcionan a unos 8 MHz

y ofrecen un máximo de 16 MB/s, suficiente para

conectar un módem o una tarjeta de sonido, pero muy

poco para una tarjeta de vídeo. Miden unos 14 cm y su

color suele ser negro; existe una versión aún

más antigua que mide sólo 8,5 cm.

Slots ISA –VESA

Local Bus: un modelo de efímera vida: se

empezó a usar en los 486 y se dejó de usar en

los primeros tiempos del Pentium. Son un desarrollo a partir

de ISA, que puede ofrecer unos 160 MB/s a un máximo de

40 MHz. Son larguísimas, unos 22 cm, y su color suele

ser negro, a veces con el final del conector en marrón

u otro color.Slots PCI

El estándar actual. Pueden dar hasta 132 MB/s

a 33 MHz, lo que es suficiente para casi todo, excepto

quizá para algunas tarjetas de vídeo 3D. Miden

unos 8,5 cm y generalmente son blancas.

Slots AGP

O más bien ranura, ya que se dedica

exclusivamente a conectar tarjetas de vídeo 3D, por lo

que sólo suele haber una; además, su propia

estructura impide que se utilice para todos los

propósitos, por lo que se utiliza como una ayuda para

el PCI. Según el modo de funcionamiento puede ofrecer

264 MB/s o incluso 528 MB/s. Mide unos 8 cm y se encuentra

bastante separada del borde de la placa.Las placas actuales tienden a tener los más

conectores PCI posibles, manteniendo uno o dos conectores ISA

por motivos de compatibilidad con tarjetas antiguas y usando

AGP para el vídeo.

CNR

La ranura CNR se encuentra en el lado

de la placa base, cerca de la última ranura PCI. Como

se puede ver comparando las figuras 1 y 4, AMR y CNR

dispositivos son un poco diferentes, aunque el caso de las

franjas horarias son muy similares. No sólo el

conector de borde (la parte que va en la ranura) es

diferente, la tarjeta tiene una orientación diferente.

El lado que tiene el conectores I / O en un dispositivo de

AMR se encuentra a la izquierda, y esta parte en un

dispositivo CNR se encuentra a la derecha

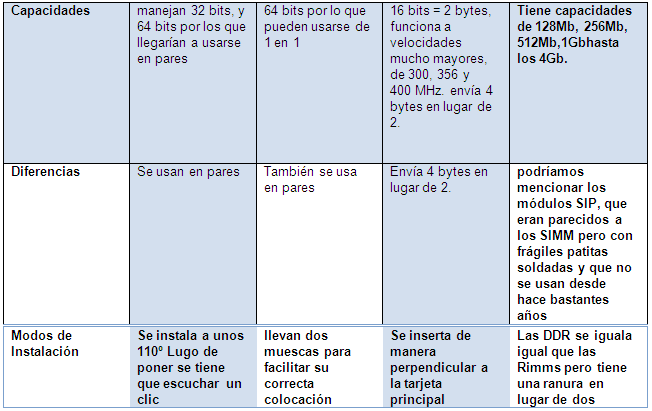

Con un grafico describa los bancos

de memoria RAMSIMM

Siglas de Single In line Memory Module,

un tipo de encapsulado consistente en una pequeña

placa de circuito impreso que almacena chips de memoria, y

que se inserta en un zócalo SIMM en la placa madre o

en la placa de memoria. Los SIMMs son más

fáciles de instalar que los antiguos chips de memoria

individuales, y a diferencia de ellos son medidos en bytes en

lugar de bits.El primer formato que se hizo popular

en los computadores personales tenía 3.5" de largo y

usaba un conector de 32 pins. Un formato más largo de

4.25", que usa 72 contactos y puede almacenar hasta 64

megabytes de RAM es actualmente el más

frecuente.Un PC usa tanto memoria de nueve bits

(ocho bits y un bit de paridad, en 9 chips de memoria RAM

dinámica) como memoria de ocho bits sin paridad. En el

primer caso los ocho primeros son para datos y el noveno es

para el chequeo de paridad.DIMM

Siglas de Dual In line Memory Module,

un tipo de encapsulado, consistente en una pequeña

placa de circuito impreso que almacena chips de memoria, que

se inserta en un zócalo DIMM en la placa madre y usa

generalmente un conector de 168 contactos.RIMM

Acrónimo de Rambus Inline Memory

Module, designa a los módulos de memoria RAM que

utilizan una tecnología denominada RDRAM, desarrollada

por Rambus Inc. a mediados de los años 1990 con el fin

de introducir un módulo de memoria con niveles de

rendimiento muy superiores a los módulos de memoria

SDRAM de 100 Mhz y 133 Mhz

disponibles en aquellos años.Los módulos RIMM RDRAM cuentan con 184 pines

y debido a sus altas frecuencias de trabajo requieren de

difusores de calor consistentes en una placa metálica

que recubre los chips del módulo. Se basan en un bus

de datos de 16 bits y están disponibles en velocidades

de 300MHz (PC-600), 356 Mhz (PC-700), 400 Mhz (PC-800) y 533

Mhz (PC-1066) que por su pobre bus de 16 bits tenía un

rendimiento 4 veces menor que la DDR. La RIMM de 533MHz tiene

un rendimiento similar al de un módulo DDR133, a pesar

de que sus latencias son 10 veces peores que la

DDR.Inicialmente los módulos RIMM fueron introducidos

para su uso en servidores basados en Intel Pentium 4. Rambus

no manufactura módulos RIMM si no que tiene un sistema

de licencias para que estos sean manufacturados por terceros

siendo Samsung el principal fabricante de éstos.A

pesar de tener la tecnología RDRAM niveles de

rendimiento muy superiores a la tecnología SDRAM y las

primeras generaciones de DDR RAM, debido al alto costo de

esta tecnología no han tenido gran aceptación

en el mercado de PC. Su momento álgido tuvo lugar

durante el periodo de introducción del Pentium 4 para

el cual se diseñaron las primeras placas base, pero

Intel ante la necesidad de lanzar equipos más

económicos decidió lanzar placas base con

soporte para SDRAM y más adelante para DDR RAM

desplazando esta última tecnología a los

módulos RIMM del mercado.DDR:

Los módulos DDR SDRAM

(Double Data Rate SDRAM) son una evolución de

los módulos SDR. Se trata de módulos del tipo

DIMM, de 184 contactos y 64bits, con una velocidad

de bus de memoria de entre 100MHz y 200MHz, pero al realizar

dos accesos por ciclo de reloj las velocidades efectivas de

trabajo se sitúan entre los 200MHz y los 400MHz. Este

es un punto que a veces lleva a una cierta confusión,

ya que tanto las placas base como los programas de

información de sistemas las reconocen unas veces por

su velocidad nominal y otras por su velocidad efectiva.

Comienzan a utilizarse con la salida de los Pentium

4 y Thlon XP, tras el fracasado intento por

parte de Intel de imponer para los P4 un tipo de memoria

denominado RIMM, que pasó con más pena que

gloria y tan sólo llegó a utilizarse en las

primeras versiones de este tipo de procesadores (Pentium 4

Willamette con socket 423). Se han hecho pruebas con

módulos a mayores velocidades, pero por encima de los

200MHz (400MHz efectivos) suele bajar su efectividad. Esto,

unido al coste y a la salida de los módulos del tipo

DDR2, ha hecho que en la práctica sólo se

comercialicen módulos DDR de hasta 400MHz (efectivos).

Estas memorias tienen un consumo de entre 0 y 2.5 voltios.

Este tipo de módulos se está abandonando,

siendo sustituido por los módulos del tipo

DDR2.6.- Cual es la función de la

memoria cache describaUn caché es un sistema especial

de almacenamiento de alta velocidad. Puede ser tanto un

área reservada de la memoria principal como un

dispositivo de almacenamiento de alta velocidad

independiente. Hay dos tipos de caché frecuentemente

usados en las computadoras personales: memoria caché y

caché de disco. Una memoria cache, llamada

también a veces almacenamiento caché o RAM

caché, es una parte de memoria RAM estática de

alta velocidad (SRAM) más que la lenta y barata RAM

dinámica (DRAM) usada como memoria principal. La

memoria cache es efectiva dado que los programas acceden una

y otra vez a los mismos datos o instrucciones. Guardando esta

información en SRAM, la computadora evita acceder a la

lenta DRAM.Cuando se encuentra un dato en la

caché, se dice que se ha producido un acierto, siendo

un caché juzgado por su tasa de aciertos (hit

rate). Los sistemas de memoria caché usan una

tecnología conocida por caché inteligente en la

cual el sistema puede reconocer cierto tipo de datos usados

frecuentemente. Las estrategias para determinar qué

información debe de ser puesta en el cache constituyen

uno de los problemas más interesantes en la ciencia de

las computadoras. Algunas memorias cache están

construidas en la arquitectura de los microprocesadores. Por

ejemplo, el procesador Pentium II tiene una caché L2

de 512 Kbytes.La caché de disco trabaja sobre

los mismos principios que la memoria caché, pero en

lugar de usar SRAM de alta velocidad, usa la convencional

memoria principal. Los datos más recientes del disco

duro a los que se ha accedido (así como los sectores

adyacentes) se almacenan en un buffer de memoria. Cuando el

programa necesita acceder a datos del disco, lo primero que

comprueba es la cache del disco para ver si los datos ya

están ahí. La cache de disco puede mejorar

drásticamente el rendimiento de las aplicaciones, dado

que acceder a un byte de datos en RAM puede ser miles de

veces más rápido que acceder a un byte del

disco duro.7.-Con un grafico demuestre las

formas de conexiones de los siguientes

dispositivosFloppy

Montar el floppy y conectar a

tensión y a su bus de datos adecuadamente tonando en

cuenta el pin 1Disco duro

Una vez montado en el soporte con

tornillosEl instalado del lector, quemador y disco duro (HD)

se la hace de una sola forma ya que se tiene que colocar un

Puente (Jhanpear) a cada uno de ellos ya sea master o esclavo

de la misma manera tambien un conector de alimentación

de tencion y Buses de 40 o 80 pines

8.-con u grafico muestra la

diferencia y la forma de conexión entre bus de 40

pines y bus de 80 pinesEl bus de 40 su división es mas notable de

hilo a hilo

En el bus de 80 su división de hilo a hilo es

un poco mas fino

9.-Con un grafico describa los tipos

de procesadores que conoce (marcas y modelos)

Los prcesadores intel P I , PII, PIII,

PIV , Prescott , Pentium D, Core Duo, Core 2 Duo , Core Quad

,Core 2Quad, i3, i5, i710.- explique que es un

microprocesador en:Características

El microprocesador o CPU, es el cerebro

de la computadora determina que tanta de memoria puede

utilizar el sistema, que clase de programas puede correr y

que tan velozmente puede avanzar. (Existen multitud de

procesadores y es muy difícil reconocerlos si no se

tiene experiencia)Funciones

Las funciones del microprocesador esta a

través de La Frecuencia (Cantidad de ciclos que se

suscitan en un segundo c.p.s. [Hertz = Hz]) es la unidad que

utilizamos para medir la velocidad del Sistema. Si todas las

demás características fueran iguales, una

máquina de 400MHz. sería más

rápida que otra de 333MHz. (Sin embargo no todas la

son.)11.-Con un grafico muestre la forma

de ensamblar el CPU en un socket y en un slotssockets

Slots

12.-Cual es la diferencia entre las

marcas de procesadores.Entre las diferencias de procesadores

mas que todo estaría en que algunas marcas tienen

procesadores de mayor capacidad y mas garantizadas que otras

en el cual el cliente prefiere mas de esa calidad pero de

bajo precio.13.-Cual sus características del

procesador de ultimo lanzamiento en el

mercado.Intel Core i7 es una familia de

procesadores de cuatro núcleos de la

arquitectura Intel x86-64. Los Core i7 son los

primeros procesadores que usan la micro arquitectura

Nehalem de Intel y es el sucesor de la

familia Intel Core 2. El identificador Core

i7 se aplica a la familia inicial de

procesadores1 2 con el nombre

clave Bloomfield.3El pseudónimo Core i7 no tiene un

significado concreto, pero continúa con el uso de la

etiqueta Core. Estos procesadores, primero ensamblados

en Costa Rica, fueron comercializados el 17 de

noviembre de 2008, y actualmente es manufacturado

en lasplantas de fabricación que

posee Intel en Arizona, Nuevo

México y Oregón, aunque la de

Oregón se prepara para la fabricación de la

siguiente generación de procesadores de 32 nm.14.-Describa como verifica los

microprocesadores.

La primera cifra significa la velocidad

para el ejemplo 2.8 Ghz la segunda memoria cache, para el

ejemplo 1MBLa tercera cifra es la velocidad

frontal de bus (fsb)15.-Que función cumplen las

tarjetas de video y cuales son sus

características.Otro elemento indispensable para armar una

computadora es la tarjeta de video que se encargara de enviar

al monitor las señales nesesarias para que en la

pantalla pueda desplegar la informacion que nos interesa

poreso elijamos las targetas de mayor transferencia como son

las vesa o las pci la tarjeta isa es sumamente lenta, otro

punto en el que devemos fijarnos es en la cantidad de memoria

que posea la tarjeta de video ya que entre mayor memoria

tenga nuestro monitor tendra mayor resolucion de colores

tendra mayor resolucion y colores lo que setraduce en

imajenes mas agradables a la vista por ello para las

aplicaciones modernas es recomendable unos coantos mbs en

video ram es facil reconocer la rtargeta de video por su

conector.17.-Por el uso de slots, cuantos

tipos de tarjetas de video conoce.La tarjeta gráfica, como añadido que

es al PC, se conecta a éste mediante un slot o ranura

de expansión. Muchos tipos de ranuras de

expansión se han creado precisamente para satisfacer a

la ingente cantidad de información que se transmite

cada segundo a la tarjeta gráfica.ISA: el conector original del PC, poco

apropiado para uso gráfico; en cuanto llegamos a

tarjetas con un cierto grado de aceleración resulta

insuficiente. Usado hasta las primeras VGA

"aceleradoras gráficas", aquellas que no sólo

representan la información sino que aceleran la

velocidad del sistema al liberar al microprocesador de parte

de la tarea gráfica mediante diversas

optimizaciones.VESA Local Bus: más que un slot un

bus, un conector íntimamente unido al microprocesador,

lo que aumenta la velocidad de transmisión de datos.

Una solución barata usada en muchas placas 486, de

buen rendimiento pero tecnológicamente no muy

avanzada.PCI: el estándar para conexión

de tarjetas gráficas (y otros múltiples

periféricos). Suficientemente veloz para las tarjetas

actuales, si bien algo estrecho para las 3D que se

avecinan.AGP (Advanced Graphics Port): tampoco un

slot, sino un puerto (algo así como un bus local),

pensado únicamente para tarjetas gráficas que

transmitan cientos de MB/s de información,

típicamente las 3D. Presenta poca ganancia en

prestaciones frente a PCI, pero tiene la ventaja de que las

tarjetas AGP pueden utilizar memoria del sistema como memoria

de vídeo (lo cual, sin embargo, penaliza el

rendimiento).En cualquier caso, el conector sólo puede

limitar la velocidad de una tarjeta, no la eleva, lo que

explica que algunas tarjetas PCI sean muchísimo

más rápidas que otras AGP más

baratas.18.-Con un grafico explique

detalladamente las memorias RAM referente a:

La memoria RAM (Random Access Memory

Module o memoria de acceso aleatorio) es un tipo de memoria

que utilizan los ordenadores para almacenar los datos y

programas a los que necesita tener un rápido acceso.

Se trata de una memoria de tipo volátil, es decir, que

se borra cuando apagamos el ordenador, aunque también

hay memorias RAM no volátiles (como por ejemplo las

memorias de tipo flash. Los datos almacenados en la memoria

RAM no sólo se borran cuando apagamos el ordenador,

sino que tambien deben eliminarse de esta cuando dejamos de

utilizarlos (por ejemplo, cuando cerramos el fichero que

contiene estos datos). Estas memorias tienen unos tiempos de

acceso y un ancho de banda mucho más rápido que

el disco duro, por lo que se han convertido en un factor

determinante para la velocidad de un ordenador. Esto quiere

decir que, dentro de unos límites, un ordenador

irá más rápido cuanta mayor sea la

cantidad de memoria RAM que tenga instalada, expresada en

MegaBytes o GigaBytes. Los chips de memoria suelen ir

conectados a unas plaquitas denominadas módulos, pero

no siempre esto ha sido así, ya que hasta los

ordenadores del tipo 8086 los chips de memoria RAM estaban

soldados directamente a la placa base. Con los ordenadores

del tipo 80386 aparecen las primeras memorias en

módulos, conectados a la placa base mediante

zócalos, normalmente denominados bancos de memoria, y

con la posibilidad de ampliarla (esto, con los ordenadores

anteriores, era prácticamente imposible). Los primeros

módulos utilizados fueron los denominados SIMM (Single

In-line Memory Module). Estos módulos tenían

los contactos en una sola de sus caras y podían ser de

30 contactos (los primeros), que posteriormente pasaron a ser

de 72 pines.Módulos SIMM. de 72 pines.SIMM de 30 pines

Este tipo de módulo de memoria

fue sustituido por los módulos del tipo DIMM (Dual

In-line Memory Module), que es el tipo de memoria que se

sigue utilizando en la actualidad. Esta clasificación

se refiere exclusivamente a la posición de los

contactos. En cuanto a los tipos de memoria, la

clasificación que podemos hacer es la siguiente:

DRAM: Las memorias DRAM (Dynamic RAM) fueron las

utilizadas en los primeros módulos (tanto en los SIMM

como en los primeros DIMM). Es un tipo de memoria más

barata que la SDRAM, pero también bastante más

lenta, por lo que con el paso del tiempo ha dejado de

utilizarse. Esta memoria es del tipo asíncronas, es

decir, que iban a diferente velocidad que el sistema, y sus

tiempos de refresco eran bastante altos (del orden de entre

80ns y 70ns), llegando en sus últimas versiones, las

memorias EDO-RAM a unos tiempos de refresco de entre 40ns y

30ns. SDRAM: Las memorias SDRAM (Synchronous Dynamic

RAM) son las utilizadas actualmente (aunque por SDRAM se

suele identificar a un tipo concreto de módulos, en

realidad todos los módulos actuales son SDRAM). Son un

tipo de memorias síncronas, es decir, que van a la

misma velocidad del sistema, con unos tiempos de acceso que

en los tipos más recientes son inferiores a los 10ns,

llegando a los5nsenlosmárápidos. Las memorias

SDRAM se dividan a su vez en varios tipos SDR:

Módulo SDR. Se pueden ver las

dos muescas de posicionamiento.DIMM de 168 pines— esta probablemente

es la que tienes.

DIMM de 184 pines— esto es lo llamado

memoria DDR

Los módulos SDR (Single Data

Rate) son los conocidos normalmente como SDRAM, aunque, como

ya hemos dicho, todas las memorias actuales son SDRAM. Se

trata de módulos del tipo DIMM, de 168 contactos, y

con una velocidad de bus de memoria que va desde los 66MHz a

los 133MHz. Estos módulos realizan un acceso por ciclo

de reloj. Empiezan a utilizarse con los Pentium II y su

utilización llega hasta la salida de los Pentium 4 de

Intel y los procesadores Athlon XP de AMD, aunque las

primeras versiones de este último podían

utilizar memorias SDR. Este tipo de módulos se

denominan por su frecuencia, es decir, PC66, PC100 o PC133.

DDR:

Módulo DDR. Vemos que tiene una

sola muesca de posicionamiento, situada a la derecha del

centro del módulo. Los módulos DDR SDRAM

(Double Data Rate SDRAM) son una evolución de los

módulos SDR. Se trata de módulos del tipo DIMM,

de 184 contactos y 64bits, con una velocidad de bus de

memoria de entre 100MHz y 200MHz, pero al realizar dos

accesos por ciclo de reloj las velocidades efectivas de

trabajo se sitúan entre los 200MHz y los 400MHz. Este

es un punto que a veces lleva a una cierta confusión,

ya que tanto las placas base como los programas de

información de sistemas las reconocen unas veces por

su velocidad nominal y otras por su velocidad efectiva.

Comienzan a utilizarse con la salida de los Pentium 4 y Thlon

XP, tras el fracasado intento por parte de Intel de imponer

para los P4 un tipo de memoria denominado RIMM, que

pasó con más pena que gloria y tan sólo

llegó a utilizarse en las primeras versiones de este

tipo de procesadores (Pentium 4 Willamette con socket 423).

Se han hecho pruebas con módulos a mayores

velocidades, pero por encima de los 200MHz (400MHz efectivos)

suele bajar su efectividad. Esto, unido al coste y a la

salida de los módulos del tipo DDR2, ha hecho que en

la práctica sólo se comercialicen

módulos DDR de hasta 400MHz (efectivos). Estas

memorias tienen un consumo de entre 0 y 2.5 voltios. Este

tipo de módulos se está abandonando, siendo

sustituido por los módulos del tipo DDR2.

DDR2:

Módulo DDR2. Vemos que tiene una

sola muesca de posicionamiento, situada a la derecha del

centro del módulo, aunque más hacia en centro

que en los módulos DDR. También se puede

apreciar la mayor densidad de contactos.Los módulos DDR2 SDRAM son una

evolución de los módulos DDR SDRAM. Se trata de

módulos del tipo DIMM, en este caso de 240 contactos y

64bits. Tienen unas velocidades de bus de memoria real de

entre 100MHz y 266MHz, aunque los primeros no se

comercializan. La principal característica de estos

módulos es que son capaces de realizar cuatro accesos

por ciclo de reloj (dos de ida y dos de vuelta), lo que hace

que su velocidad de bus de memoria efectiva sea el resultado

de multiplicar su velocidad de bus de memoria real por 4.

Esto duplica la velocidad en relación a una memoria

del tipo DDR, pero también hace que los tiempos de

latencia sean bastante más altos (pueden llegar a ser

el doble que en una memoria DDR). El consumo de estas

memorias se sitúa entre los 0 y 1.8 voltios, es decir,

casi la mitad que una memoria DDR.Tanto las memorias DDR como las

memorias DDR2 se suelen denominar de dos formas diferentes, o

bien en base a su velocidad de bus de memoria efectiva

(DDR-266, DDR-333, DDR-400, DDR2-533, DDR2-667, DDR2-800) o

bien por su ancho de banda teórico, es decir, por su

máxima capacidad de transferencia (PC-2100, PC-2700 y

PC-3200 en el caso de los módulos DDR y PC-4200,

PC-5300 y PC-6400 en el caso de los módulos DDR2). El

Ancho de banda de los módulos DDR y DDR2 se puede

calcular multiplicando velocidad de bus de memoria efectiva

por 8 (DDR-400 por 8 = PC-3200). El último y

más reciente tipo de memorias es el DDR3.

Módulo DDR. Vemos que tiene una

sola muesca de posicionamiento, situada en esta

ocasión a la izquierda del centro del módulo.

Este tipo de memorias (que ya han empezado a comercializarse,

y están llamadas a sustituir a las DDR2) son

también memorias del tipo SDRAM DIMM, de 64bits y 240

contactos, aunque no son compatibles con las memorias DDR2,

ya que se trata de otra tecnología y además

físicamente llevan la muesca de posicionamiento en

otra situación. Según las informaciones

disponibles se trata de memorias con una velocidad de bus de

memoria real de entre 100MHz y 250MHz, lo que da una

velocidad de bus de memoria efectiva de entre 800MHz y

2000MHz (el doble que una memoria DDR2 a la misma velocidad

de bus de memoria real), con un consumo de entre 0 y 1.5

voltios (entre un 16% y un 25% menor que una DDR2) y una

capacidad máxima de transferencia de datos de

15.0GB/s. En cuanto a la medida, en todos los casos de

memorias del tipo SDRAM (SDR, DDR, DDR2 y DDR3) se trata de

módulos de 133mm de longitud. En cuanto a su

instalación, pueden ver una amplia información

de cómo se instalan en el tutorías –

Instalación y ampliación de módulos de

memoria.. Una cuestión a considerar es que estos tipos

de módulos no son compatibles entre sí, para

empezar porque es físicamente imposible colocar un

módulo en un banco de memoria que no sea de su tipo,

debido a la posición de la muesca de posicionamiento.

Hay en el mercado un tipo de placas base llamadas normalmente

duales (OJO, no confundir esto con la tecnología Dual

Channel) que tienen bancos para dos tipos de módulos

(ya sean SDR y DDR o DDR y DDR2), pero en estos casos tan

sólo se puede utilizar uno de los tipos. Esto quiere

decir que en una placa base dual DDR – DDR2, que normalmente

tiene cuatro bancos (dos para DDR y otros dos para DDR2),

podemos poner dos módulos DDR o dos módulos

DDR2, pero NO un módulo DDR y otro DDR2 o ninguna de

sus posibles combinaciones. Es decir, que realmente

sólo podemos utilizar uno de los pares de bancos, ya

sea el DDR o el DDR2. En nuestra sección de Tutoriales

disponemos de más documentos en los que pueden

encontrar una mayor información sobre este tema. Les

aconsejo leer los siguientes:19.-cual sus características

de las tarjetas de sonido.La tarjeta de sonido se caracteriza por tener

funciones principales que son la generación o

reproducción de sonido y la entrada o grabación

del mismo. Para reproducir sonidos, las tarjetas incluyen un

chip sintetizador que genera ondas musicales, Una buena

tarjeta de sonido, además de incluir la

tecnología WaveTable, debe permitir que se

añada la mayor cantidad posible de memoria. Algunos

modelos admiten hasta 28 Megas de RAM (cuanta más,

mejor).El criterio más inteligente es tener claro

para qué la vamos a utilizar: si vamos a pasar la

mayor parte del tiempo jugando, podemos prescindir de

elementos avanzados, más enfocados a profesionales del

sonido. En cualquier caso, ya sabes: la elección es

personal.

20.-Que función cumple el bus

de audio analógico en una tarjeta de sonido o en un

lector o quemador de CD.Además de tener conectores externos, los hay

también internos, siendo el más importante el

que va al CD-ROM, para poder escuchar los CDs de

música. Puede ser digital (sólo en los

más modernos) o el típico analógico. del

cual hace tiempo había varios formatos (para CD-ROMs

Sony, Mitsumi, IDE…) ahora ya unificados. Y en algunas

tarjetas antiguas se incluía un conector IDE de 40

pines para el CD-ROM (cuando los CD-ROMs eran algo "extra" y

no existía el EIDE con sus 2 canales).21.-Cual sus características

y capacidades de las tarjetas de Fax Modem.Módem es un acrónimo de

Modulador-demodulador; es decir, que es un dispositivo que

transforma las señales digitales del ordenador en

señal telefónica analógica y viceversa,

con lo que permite al ordenador transmitir y recibir

información por la línea

telefónica.Los chips que realizan estas funciones

están casi tan estandarizados como los de las tarjetas

de sonido; muchos fabricantes usan los mismos integrados, por

ejemplo de la empresa Rockwell, y sólo se diferencian

por los demás elementos electrónicos o la

carcasa22.-Explique en que gravitan las

versiones de las tarjetas de Fax MODEM.Su uso más común y conocido es en

transmisiones de datos por

vía telefónica.Las computadoras procesan datos de

forma digital; sin embargo, las líneas

telefónicas de la red básica sólo

transmiten señales analógicas.Los métodos de modulación y otras

características de los módems

telefónicos están estandarizados por

elUIT-T (el antiguo CCITT) en la serie de

Recomendaciones "V". Estas Recomendaciones también

determinan la velocidad de transmisión.

Destacan:V.21.

Comunicación Full-Duplex entre dos

módems analógicos realizando una

variación en la frecuencia de la portadora de un

rango de 300 baudios, logrando una transferencia de

hasta 300 bps (bits por segundo).V.22.

Comunicación Full-Duplex entre dos

módems analógicos utilizando una

modulación PSK de 600 baudios para

lograr una transferencia de datos de hasta 600 o 1200

bps.V.32. Transmisión a

9.600 bps.V.32bis. Transmisión a 14.400

bps.V.34. Estándar de módem que

permite hasta 28,8 Kbps de transferencia de datos

bidireccionales (full-duplex), utilizando

modulación en PSK.

Página anterior Página anterior |   Volver al principio del trabajo Volver al principio del trabajo | Página siguiente  |