Página anterior Página anterior |   Voltar ao início do trabalho Voltar ao início do trabalho | Página seguinte  |

A vantagem de adoção do sistema em raster está na necessidade de modelar o dado desde a sua representação inicial, até o seu cruzamento com outros dados. A aplicação de processos de consultas, cruzamentos e ponderações de variáveis requerem o conhecimento das características específicas do dado, o seu modo de coleta, assim como a adoção de modelos de análise. Assim, a proposta é a de representação de variáveis em planos de informação armazenados na forma de matrizes.

O trabalho em planos de informação, segundo XavierdaSilva (2001, p. 67) é a adoção de uma matriz tridimensional Ai,j,k, na qual há um referencial geográfico (estrutura de georreferenciamento) e a latitude e a longitude definem a localização de qualquer ponto contido na base de dados. O eixo "k" define a posição do ponto nas diferentes referenciais taxonômicos, que são conjuntos de variáveis classificadoras do espaço (temas). Ex.: Um ponto apresenta posição "x" e "y" em latitude e longitude, classificação taxonômica como um tipo de solo "a", uma classe de declividade "aa", e uso da terra tipo "aaa".

É importante definir a unidade territorial de integração das análises, o que significa a escolha da resolução dos planos de informação e, conseqüentemente, a resolução ou precisão espacial das análises geradas. Para ser possível o cruzamento de dados os planos de informação deverão apresentar todos a mesma resolução de armazenamento, ainda que suas elaborações tenham sido realizadas em outras resoluções. A definição da resolução é a escolha do tamanho do pixel na composição dos mapas em formato raster e do número de linhas e colunas na matriz de representação, conforme representado na Figura 1.

Figura 1 Coincidência espacial sobreposição de planos de informação de mesma resolução. Representação matricial em linhas e colunas, com a dimensão do pixel definindo a resolução. (Moura, 2003, p. 70).

E comum que em uma análise espacial as variáveis que compõem os planos de informação apresentem fontes de dados diferentes e escalas diferentes, o que resultaria em possibilidades diferentes de resoluções espaciais. O procedimento indicado é a adoção da pior resolução entre as praticadas (maior dimensão de pixel), pois não é cartograficamente correto reduzir a resolução e melhorar a representação de um dado cuja fonte era de pior qualidade.

Para exemplificar a questão da resolução comum, podese considerar o caso um conjunto de planos de informação seja composto pela camada de recursos hídricos (escala 1:50.000), uso do solo (escala 1:150.000 ou pixel de 30 metros) e pela camada de eixos rodoviários (escala 1:25.000). A camada de recursos hídricos poderia ser representada com a resolução ou pixel de 10 metros (0,2mm na escala da fonte), a camada de uso do solo com pixel de 30 metros e a camada de eixos rodoviários com a resolução ou pixel de 5 metros. Contudo, não seria possível aplicar modelos de cruzamento das camadas devido às diferentes resoluções, o que obriga a reamostragem em uma unidade comum, que é denominada unidade territorial de integração. O correto, cartograficamente, é a adoção da pior resolução, no caso o pixel de 30 metros, por processo de generalização cartográfica. Uma vez construída a análise, o resultado final é válido para a resolução de 30 metros.

As etapas indicadas para a montagem de um sistema de geoprocessamento são as seguintes:

a. Definição dos objetivos e aplicações no uso do sistema de análise apoiada por geoprocessamento.

b. Organização da base de dados alfanumérica e cartográfica para montagem do SIG: organização da base cartográfica e alfanumérica; definição dos modos de representação espacial dos dados; conversão de escalas de medição; conversão de dados vetoriais em matriciais (raster).

c. Uso do SIG nas análises ambientais: escolha e aplicação dos modelos de análise espacial; validação frente à realidade (para verificação dos resultados); se necessário, calibração do sistema pelo ajuste do modelo e retorno às etapas de análise.

XavierdaSilva (1999b, p.2) explica que a pesquisa ambiental parte dos seguintes pressupostos: todo fenômeno é passível de ser localizado; todo fenômeno tem sua extensão determinável; todo fenômeno está em constante alteração; todo fenômeno apresentase com relacionamentos, não sendo registrável qualquer fenômeno totalmente isolado; segundo o postulado da causalidade, é possível revelar relações causais entre as correlações associadas aos fenômenos, com margens de erro, o que leva a uma validade relativa.

Assim, ao realizar uma análise espacial baseada na conjugação de uma coleção de variáveis, é importante ter claro que os resultados obtidos cabem em um contexto no tempo e no espaço, em uma situação específica. Cada nova análise irá exigir nova escolha de conjunto de variáveis e o peso que cada uma delas terá no resultado final está relacionado ao contexto da análise.

A Análise de Multicritérios é um procedimento metodológico de cruzamento de variáveis amplamente aceito nas análises espaciais. Ela é também conhecida como Árvore de Decisões ou como Análise Hierárquica de Pesos. O procedimento baseiase no mapeamento de variáveis por plano de informação e na definição do grau de pertinência de cada plano de informação e de cada um de seus componentes de legenda para a construção do resultado final. A matemática empregada é a simples Média Ponderada, mas há pesquisadores que já utilizam a lógica Fuzzy para atribuir os pesos e notas.

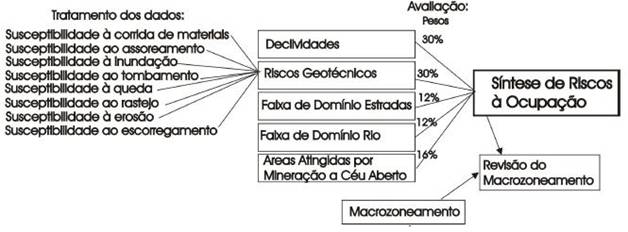

Como exemplo de cruzamento visando à construção de mapa de potencial de risco, na Figura 2 é apresentado um exemplo de geração do mapa de Síntese de Riscos à Ocupação Urbana, resultante do cruzamento de mapas de declividades, riscos geotécnicos, faixa de domínio de estradas, faixa de domínio de rios e áreas já atingidas por mineração, de acordo com esquema a seguir. Cada plano de informação recebe um peso (30%, 30%, 12%, 12% e 16%) e o conjunto soma 100%, segundo o procedimento de média ponderada. Além disto, cada componente de legenda de cada plano de informação recebe nota de 0 a 10 segundo o grau de pertinência de sua participação no conjunto. Assim, o plano de informação Declividades tem seus componentes de legenda assim ponderados: declividade de 0 a 30% nota 0, declividade de 30 a 47% nota 7 e declividade acima de 47% nota 10, significando que a alta declividade apresenta maior grau de pertinência na definição do risco do que as declividades mais baixas.

Figura 2Exemplo de Análise de Multicritérios ou Árvore de Decisões (Moura, 2003)

O emprego da Média Ponderada cria um espaço classificatório, ordinal, que pode ser também entendido como uma escala de intervalo. Esse processo pode também ser utilizado em escala nominal, desde que os eventos sejam hierarquizados segundo algum critério de valor. A ponderação deve ser feita por "knowledge driven evaluation", ou seja, por conhecedores dos fenômenos e das variáveis da situação avaliada, ou por "datadriven evaluation" que se refere ao conhecimento prévio de situações semelhantes. Nesse processo, a possibilidade de se ponderar de modo inadequado uma situação é o inverso do número de ponderações atribuídas. Para construir uma função de pertinência indicase a aplicação do método Delphi ou a consulta direta a especialistas (experts).

O método Delphi na obtenção dos pesos e notas baseiase na escolha de um grupo multidisciplinar de especialistas, que conheçam bem o fenômeno e melhor ainda se conhecerem bem a realidade espacial onde ele se localiza. A esses especialistas é solicitado que hierarquizem ou coloquem as variáveis (ou planos de informação) em ordem de importância para a manifestação ou ocorrência de fenômeno estudado. Exemplo: para a geração do mapa de Potencial de Riscos, qual é a ordem de importância das variáveis escolhidas? Seria ainda mais interessante se os especialistas fossem consultados na definição da coleção de variáveis de mapeamento. Uma vez recebidas respostas do grupo, realizase a seleção da média e a indicação do predomínio nas manifestações. O especialista então recebe

o resultado da consulta e é solicitado a rever suas posições – caso ele tenha firmeza das suas escolhas, mantém suas respostas, mas caso ele decida ajustar suas avaliações diante da resposta do grupo, ele manifesta nova opinião. Assim é feito por 2 rodadas, mas há situações em que se aplicam 3 rodadas.

Segundo o Instituto de Estudos Avançados da USP[1](2004, p.5):

"A evolução em direção a um consenso obtida no processo representa uma consolidação do julgamento intuitivo de um grupo de peritos sobre eventos futuros e tendências. A técnica baseiase no uso estruturado do conhecimento, da experiência, e da criatividade de um painel de especialistas, no pressuposto que o julgamento coletivo, quando organizado adequadamente, é melhor do que a opinião de um só indivíduo, ou mesmo de alguns indivíduos desprovidos de uma ampla variedade de conhecimentos especializados."

Na definição do número de especialistas a serem consultados, estudos do IEAUSP (op. cit) indicam, a partir de referências de Vichas (1982, apud IEAUSP, 2004), que eles podem ser entre 15 e 30 pessoas.

Os especialistas envolvidos na aplicação do Delphi devem ser mantidos em anonimato, pois informações sobre a composição da formação do grupo e suas especialidades poderiam conduzir na avaliação de um indivíduo. Caso um participante saiba, por exemplo, que nomes respeitados na área de geotecnia fazem parte do grupo, a informação pode interferir sobre suas avaliações sobre o tema.

Da mesma forma que os especialistas opinam sobre a hierarquia das variáveis, eles opinam também sobre o grau de pertinência, de 0 a 10, de cada componente de legenda, como apresentado na Tabela 1, destacando com valores maiores os elementos de maior risco:

Tabela 1Árvore de Decisões na Avaliação da Síntese de Riscos à Ocupação

|

Temas: |

Pesos: |

Componentes de Legenda: |

Notas: |

||||

|

Faixa de Domínio |

15% |

Faixa Domínio Rodovia |

10 |

||||

|

Rodovia |

|

Área fora da faixa |

0 |

||||

|

Risco Geotécnico |

30% |

Nulo |

0 |

||||

|

|

|

Remoto |

1 |

||||

|

|

|

Baixo |

3 |

||||

|

|

|

Moderado |

5 |

||||

|

|

|

Alto |

9 |

||||

|

|

|

Muito Alto |

10 |

||||

|

Declividades |

30% |

0 a 30% |

0 |

||||

|

|

|

30 a 47% |

7 |

||||

|

|

|

Acima 47% |

10 |

||||

|

Mineração a Céu |

25% |

Área atingida por Mineração |

10 |

||||

|

Aberto |

|

Área não atingida |

0 |

||||

É importante destacar que deve ser pensado cada item de modo isolado, pois a relação entre uma característica e outra será construída pela aplicação do modelo, que necessariamente cruza todos os componentes. Exemplo: se um especialista é consultado sobre o grau de pertinência de uma declividade de 30 a 47% na composição de um mapa de risco, ele não deve se ater ao fato de que a mesma declividade tem avaliações diferentes segundo a questão geotécnica, e com isto ficar inseguro em manifestar sua opinião. O método indica que teve ser avaliada cada variável por vez, e o especialista deve refletir sobre os componentes daquela variável, pois a ponderação de uma outra, como é o caso da classificação da geotecnia, também será realizada em paralelo.

Existem procedimentos aplicativos, como é o caso do AHP (Análise Hierárquica de Pesos), método desenvolvido pelo Prof. Thomas Saaty em 1978, na Universidade da Pensilvânia. Ele auxilia na atribuição dos pesos dos planos de informação, para determinar a contribuição relativa de cada um, mas ainda assim o especialista ainda deve definir a hierarquia entre as variáveis e os pesos de cada componente de legenda das variáveis. No exemplo citado, o especialista colocaria as variáveis em ordem de importância para a composição do risco à ocupação (risco geotécnico, declividades, mineração a céu aberto, faixa de domínio de rio, faixa de domínio de rodovia) e o aplicativo calcularia os valores numéricos (que somam 100%). O método propõe a comparação de variáveis par a par e é atribuído um critério de importância relativa entre eles, conforme a escala apresentada na Tabela 2. Contudo, o procedimento analisa o plano de informação de um modo geral, e não certas áreas definidas nos mapas.

Tabela 2Escala de Valores AHP para Comparação Pareada

|

Intensidade de importância |

Definição e Explicação |

||

|

1 |

Importância igual os dois fatores contribuem igualmente para o objetivo |

||

|

3 |

Importância moderada um fator é ligeiramente mais importante que o outro |

||

|

5 |

Importância essencial um fator é claramente mais importante que o outro |

||

|

7 |

Importância demonstrada um fator é fortemente favorecido e sua maior relevância foi demonstrada na prática |

||

|

9 |

Importância extrema a evidência que diferencia os fatores é da maior ordem possível. |

||

|

2,4,6,8 |

Valores intermediários entre julgamentos possibilidade de compromissos adicionais |

||

Fonte: DPI, Instituto de Pesquisas Espaciais, 2005. (www.dpi.inpe/spring)

A escolha de áreas específicas no mapa para estudar a relação entre variáveis e assim atribuir pesos, que são a hierarquia de participação de cada uma no resultado final, é um procedimento bastante eficaz. Ele baseiase em apoio de campo ou no conhecimento sobre a área e o fenômeno, de modo que são escolhidas amostras territoriais nas quais se conhece bem o resultado do fenômeno. Exemplo: no caso da Síntese de Riscos à Ocupação seriam escolhidas porções do território nas quais já se comprovou o alto risco e os estudos de relações entre variáveis e a atribuição de seus pesos seria definido pelo comportamento dessas amostras. Para ampliar a segurança poderiam ser escolhidas amostras também em áreas de baixo risco.

Outra forma de atribuição de pesos é a construção de análises baseadas por estatística, de modo a identificar as situações nas quais exista baixa correlação entre as variáveis, e alta correlação com o fenômeno ou ocorrência a ser explicado. Isto porque se alta correlação entre as variáveis, ambas estariam contribuindo da mesma forma para a explicação do fenômeno (é como se uma substituísse a outra na análise, e a incorporação de ambas não faria diferença).

Contudo, é importante observar que embora existam métodos e técnicas para tirar do especialista a responsabilidade de atribuir todos os valores numéricos da análise, representados pelos pesos e notas dos planos de informação e de seus respectivos componentes de legenda, sempre haverá um nível de subjetividade. Sempre haverá a necessidade de indicar uma hierarquia entre variáveis (que se somam em 100%) ou os pesos de suas subdivisões (que recebem grau de pertinência de 0 a 10). Não existe pesquisa sem um pequeno traço de subjetividade, pois a própria escolha de um modelo já é a opinião de um especialista segundo uma olhar sobre a realidade espacial. Contudo, confiase no conhecimento especialista, pois esses profissionais, no diaadia, "...fazem suposições quase que precisas em seus domínios" (Levine et al.,1988, p.97).

Os produtos gerados caracterizaram zoneamentos segundo diferentes variáveis ambientais, com identificação de situações especiais que caracterizam a área analisada, segundo conflitos, potenciais, riscos e prioridades de intervenção.

Os processos de decisão de pesos e notas das variáveis e seus componentes de legenda requerem a atribuição de valores numéricos que traduzam a hierarquia definida. Devido a essa necessidade de transformar os dados da análise em valores numéricos, há uma etapa importante de padronização de escalas de mensuração. Isto permite que dados qualitativos (descritivos ou nominais) sejam apresentados de modo quantitativo (por números) segundo a avaliação ou ranking de suas qualidades. Usando como exemplo um plano de informação "Risco Geotécnico", que contém os componentes de legenda: "alto", "médio a alto", "médio", "médio a baixo", "baixo" e "nulo"; na construção da análise eles serão transformados em valores numéricos "10", "7", "5","3", "1" e "0", visando a caracterização de valores qualitativos em quantitativos.

Segundo Moura (2003, p. 42) as escalas são nominal, ordinal, de intervalo e de razão. A escala Nominal é qualitativa ou seletiva, o que não permite a aplicação de operações aritméticas, pois não é possível dizer, por exemplo, que "cobertura vegetal" seja o dobro de "área urbana". A escala Ordinal permite ordenar os componentes segundo grandeza ou preferência, mas, como na classe anterior, não é possível a aplicação de operações aritméticas, mas somente avaliar a freqüência e a classe modal. A escala de Intervalo permite que cada observação seja inserida em uma faixa, mas o zero é arbitrário e não indica ausência da característica medida. A utilização de operações aritméticas é limitada a transformações lineares, permitindo aplicar técnicas de estatística paramétrica. A escala de Razão trabalha com intervalos conhecidos e o zero é uma origem verdadeira, o que permite a ampla utilização de operações aritméticas e aplicações de técnicas de estatística paramétrica.

A forma utilizada para a transformação de qualquer escala de mensuração em valores numéricos é a atribuição de pesos para os planos de informação (de modo a somarem 100% em média ponderada) e de notas de 0 a 10 para os componentes de legenda, visando a responder à questão: qual a importância desse fator para a síntese em construção? A resposta parte do princípio de que não se pode definir simplesmente como "sim" ou "não" a importância da participação de uma variável no conjunto, mas devese caracterizála segundo o grau de pertinência para o objetivo de análise, o que é operacionalizado por atribuição de pesos e notas. Assim, a natureza binária é pouco adaptável a situações reais, enquanto a natureza contínua capta melhor a subjetividade das situações.

A metodologia de análise espacial baseada em cruzamento de planos de informação em formato matricial começa com a montagem da base de dados e a espacialização destes em mapas georreferenciados. Uma vez montados os mapas, ou planos de informação, há softwares de livredomínio ou comerciais que disponibilizam ferramentas para procedimentos diagnósticos e procedimentos prognósticos. Os procedimentos diagnósticos caracterizamse pela análise da situação espacial vigente, enquanto os prognósticos, somandose aos conhecimentos dos diagnósticos, permitem antever situações e construir propostas de intervenção ambiental.

A análise de multicritérios se destina ao desenvolvimento de estudos caracterizadores da realidade vigente e preditivos de situações futuras. A primeira etapa, cujo objetivo é caracterizar a realidade, promove espacialização das informações, cálculo de suas extensões territoriais de ocorrências, identifica as alterações espaciais ao longo do tempo e verifica as combinações de variáveis que caracterizam determinado fenômeno espacial. Como exemplo do estudo de uma ocorrência de interesse (por exemplo uma quadra ou as áreas de declividade superior a 30%) é promovida uma varredura dos diferentes planos de informação, de modo a identificar o que ocorre naquela geografia em relação aos temas abordados. Por exemplo, em áreas de declividade superior a 30% ocorrem n hectares (ou um percentual em relação ao total) de uso do solo caracterizado por mata, n hectares de tipo de solo cambissolo, e daí por diante.

A etapa seguinte, de estudos preditivos de situações futuras, pode ser entendida como a composição de potenciais gerados a partir da combinação de variáveis, por Análise de Multicritérios, conjugadas segundo indicações dos especialistas sobre suas composições e seus comportamentos, pelo método Delphi. Entre os estudos realizados desta forma estão os riscos ambientais, potenciais ambientais e definição de necessidades de proteção. O cruzamento destas análises pode gerar respostas mais complexas, como as incongruências de uso, áreas críticas, potenciais conflitantes e impactos ambientais.

As avaliações por Análise de Multicritérios permitem, ainda, as análises espaciais preditivas, ou seja, o ifthen. As simulações são realizadas quando são introduzidas características ambientais fictícias a um conjunto de dados, e são construídas análises que dão respostas sobre as conformações espaciais tendo como componentes aquelas situações hipotéticas. É o caso, por exemplo, de apresentar um mapa fictício indicando a existência de um tipo de uso do solo em certa região, a partir disto realizar a análise desses dados junto com outros parâmetros (como o estudo de potencial de riscos à ocupação). Feita a análise de multicritérios, comparar os resultados obtidos com a presença ou ausência do recurso para perceber se o impacto que uma mudança de uso do solo traria para o conjunto.

Ao longo dos processos de análise, sempre que são produzidas sínteses ou avaliações segundo algum critério, os mapas obtidos devem ser verificados segundo algum dos procedimentos:

Identificação de áreas cujas características são bastante conhecidas e verificação da classificação por elas obtida no mapa.

Uso de outras classificações ou mapeamentos de situações específicas, elaboradas por outros pesquisadores, como modo de comparação com os resultados obtidos.

Realização de trabalho de campo para verificação de certas classificações e ocorrências surgidas nas análises.

Consultas a conhecedores da realidade espacial analisada.

Caso necessário, diante das verificações citadas, as avaliações devem ser refeitas com nova escolha de variáveis, ou mudanças em seus pesos e ou atribuição de novas notas aos componentes de legenda.

Apostilas:

INPE Instituto de Pesquisas Espaciais, Divisão de Processamento de Imagens, Apostila Spring, 2005. (www.dpi.inpe/spring)

XAVIERDASILVA, Jorge. Geoprocessamento para análise ambiental. Rio de Janeiro: Lageop, 1999b. 15 p. (apostila do Curso de Especialização em Geoprocessamento Midia CDrom).

Livro:

LEVINE, Robert I., DRANG, Diane E., EDELSON, Barry. Inteligência artificial e sistemas especialistas. São Paulo: McGrawHill, 1988. p.97128.

MARTIN, David. Geographic Information System; socioeconomic applications. London: Routledge, 1996. 210 p.

MOURA, Ana Clara M. Geoprocessamento na gestão e planejamento urbano. Belo Horizonte, Ed da Autora, 2003, 294 p.

TEIXEIRA, Amandio, CHRISTOFOLETTI. Antônio, MORETTI, Edmar. Introdução aos Sistemas de Informação Geográfica. Rio Claro: Ed. dos Autores, 1992. 80 p.

XAVIERDASILVA, Jorge. Geoprocessamento para análise ambiental. Rio de Janeiro: J. Xavier da Silva, 2001. 227 p.

Relatórios Técnicos:

INSTITUTO DE ESTUDOS AVANÇADOS da USP. Projeto Brasil 3 Tempos, Dimensão Global. São Paulo, USP, 2004. 44 p. (relatório técnico).

VICHAS. R. P. Complete Handbook of Profitable Marketing Research Techniques. Englewood Cliffs, PreticeHall, Icn, 1982, apud INSTITUTO DE ESTUDOS AVANÇADOS da USP. Projeto Brasil 3 Tempos, Dimensão Global. São Paulo, USP, 2004. 44 p. (relatório técnico).

Anais XIII Simpósio Brasileiro de Sensoriamento Remoto, Florianópolis, Brasil, 21-26 abril 2007, INPE, p. 2899-2906.

Autor:

Ana Clara Mourão Moura

Universidade Federal de Minas Gerais – IGC – Depto Cartografia

Av. Antônio Carlos 6627 Pampulha 31270901 – Belo Horizonte, MG, Brasil

[1] PROJETO BRASIL 3 TEMPOS, DIMENSAO GLOBAL. Projeções Relativas á Dinâmica da Dimensão Global e Visualização Prospectiva para 2007, 2015 e 2022.

Página anterior Página anterior |   Voltar ao início do trabalho Voltar ao início do trabalho | Página seguinte  |

|

|

|